对于垂直搜索引擎来说一种新的Web爬行方法外文翻译资料

2021-12-16 23:15:14

英语原文共 6 页

对于垂直搜索引擎来说一种新的Web爬行方法

Kolli Pavanilowast; , G P Sajeevdagger;

Dept of Computer Science and Engineering (计算机科学与工程)

Amrita School of Engineering, Amritapuri (Amrita工程学院,Amritapuri)

Amrita Vishwa Vidyapeetham

Amrita University (Amrita大学)

India (印度)

Email: lowast;kollipavani9@gmail.com, dagger; sajeevgp@am.amrita.edu

摘要:Web爬虫的主要目标是检索尽可能多的相关页面,但是,大多数爬虫使用页面排名算法来排列爬行器边界中的页面。由于页面排名算法存在“富裕者更富裕现象”的缺点,因此集中的爬虫通常无法检索隐藏的相关页面。本文提出了一种通过组合秩和语义相似性信息来检索隐藏的相关页面的新方法。通过使用在不同主题上所抓取的真实网络来验证模型的可行性,其结果表明这种方法本身很有希望。

关键词 - 垂直搜索引擎,聚焦网络爬虫,页面等级,语义相似度。

一 导言

搜索引擎是在网络中使用最重要的系统,该系统具有非常大的网页索引。搜索引擎需要扩大化以应对网络上内容的快速增长[1]。即使Google等巨大的搜索引擎可以处理这些信息,但随着网站数量的增加,文档的大小迅速的增加,网站内容也经常要求得到更新。因此,搜索引擎很难做到面面俱到地去处理这些信息。例如,谷歌也只能索引到网络的60%[1]。搜索引擎的另一个问题是,他们返回的是给定搜索查询的大量结果,这个结果有着很多的冗余。因此,用户发现难以将相关内容定位到查询。搜索引擎可以使用最强大的蜘蛛,它们可以遍历网络来创建数据库。

搜索引擎根据其性能分为三种类型。像Alta Vista这样的通用搜索引擎涵盖了高度可能的信息,但结果不太相关。像Yahoo这样的目录搜索引擎将搜索范围限制在相关类别,它返回更多相关页面。主题特定搜索引擎或垂直搜索引擎则与上述两种类型不同。它是通过领域知识构建和增强的,它提供了相关的大量相关信息上面提到的类别。例如,Google学术搜索(https://scholar.google.co.in/)提供了搜索学术文献的方法。垂直搜索引擎是使用主题爬虫来构建数据库。

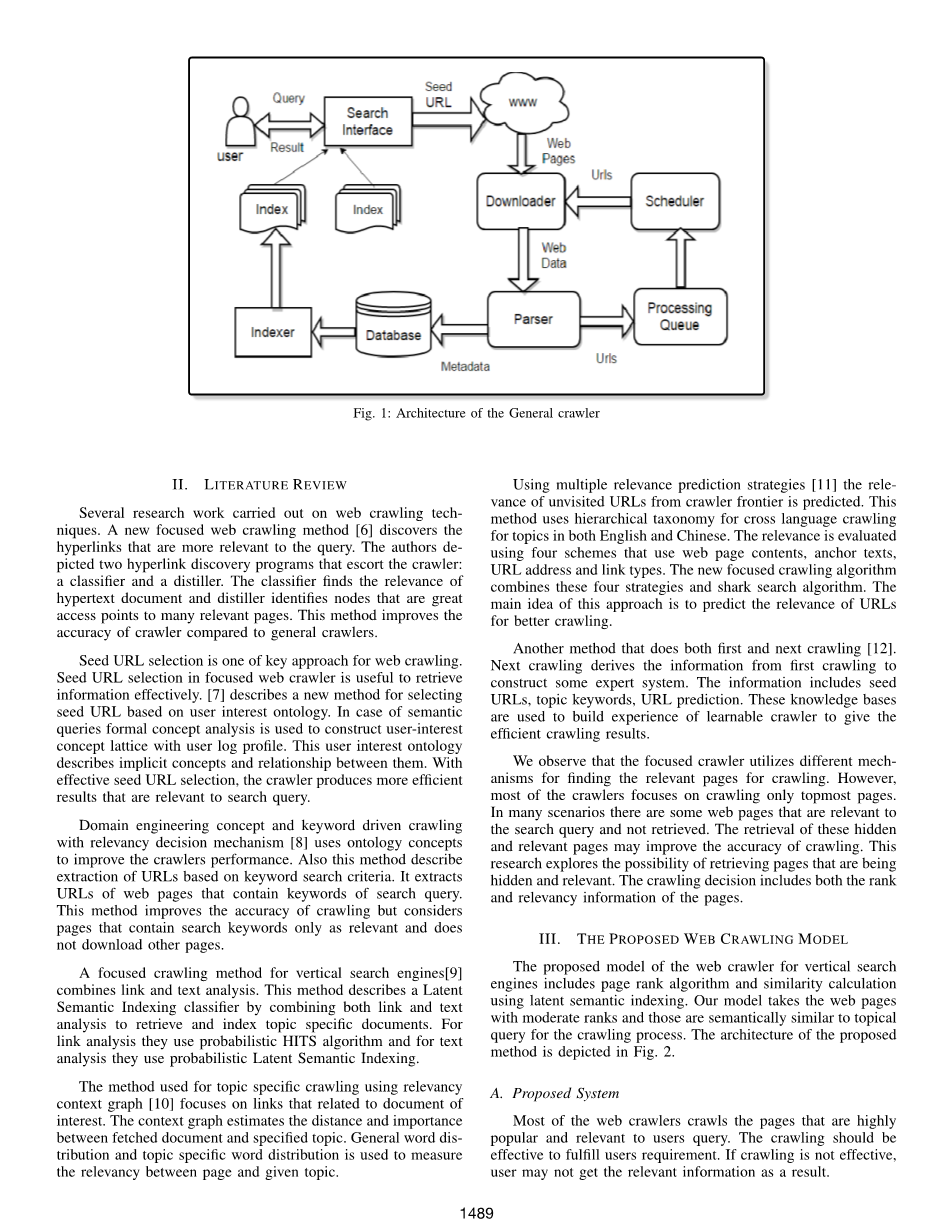

Web爬行是对Web的递归探索,用于收集连接到种子页面的每个页面[2]。 Web爬虫也称为蜘蛛。网络爬虫的主要用途是制作所有已爬行的页面的集合,供搜索引擎进行日后处理,以提供快速搜索。Web爬网程序将种子页面作为输入,并返回与种子页面相关的页面作为输出。Web爬网程序的通用体系结构如图1所示.Web爬网程序将种子页面作为输入并访问种子页面, 它从种子页面中提取内容并存储到数据库中。 它还会提取种子页面中的所有超链接,并将它们存储到包含URL集合的URL边界要被抓取 对于边界中的每个URL重复该过程。网络爬虫的主要挑战是选择性地下载相关页面,并基于在爬行器边界中分配的优先级来访问页面。

聚焦爬虫被引入以满足用户的特定需求,聚焦爬虫用于查找满足与某个特定主题相关的属性的页面[3]。聚焦的爬虫有助于以更高的准确度检索许多相关页面水平,聚焦爬虫还可提高爬行效率。大多数爬虫使用排名算法对搜索引擎结果中的页面进行排名。现今最常用的算法是页面排名算法。

页面排名算法通过计算到该页面的链接的数量和质量来衡量网页的重要性[4]。通常,页面排名算法假设最重要的站点可能从其他站点接收更多链接,由于这个原因,它遭受了“富裕者更富裕现象”[5]的缺点,这意味着那些排名较高的页面的排名总是很高,排名较低的页面的排名将保持较低。因此,对于排名较低的页面,在搜索过程中就会导致获取检索的可能性较小。考虑一下Google学者的例子,其中受欢迎的文章将显示在最顶层的结果中,并且最近上传的文章将不会显示在结果列表的第一页中,这会导致用户查询中用户很可能会错过这些新文章。此外,用户可能没有兴趣去搜索直到结果的最后一页。并且,由于页面排名算法的搜索结果基于关键词(不基于语义),因此用户很可能错过了搜索过程中的相关文章。目前的研究重点是通过过滤页面的排名和计算语义相似性来对垂直搜索引擎进行有效的爬行。我们使用页面排名算法来计算页面的排名,并基于具有特定阈值的排名来过滤页面。为了提高爬行的相关性,我们使用语义相似性信息,从而通过使用语义相似性信息,我们只抓取最相关的隐藏页面。

其余论文的结构如下。 我们在第二节介绍文献调查。 第三节解释了改进的垂直搜索引擎网络爬行方法。在第四节中,我们介绍了我们提出的方法的性能分析。第五节总结了该文件,并附有关于未来的说明工作。

图1:通用履带的结构

二 文献回顾

关于网络爬行技术的一些研究工作。一种新的聚焦网络爬行方法[6]发现了与查询更相关的超链接。其中作者描述了两个超链接发现程序来护送爬虫,这两个超链接发现程序为:分类器和蒸馏器。分类器找到超文本文档的相关性,而蒸馏器识别出很好的节点访问点来指向许多相关页面。与普通爬虫相比,此方法提高了爬虫的准确性。

种子URL选择是Web爬网的关键方法之一。在有针对性的Web爬网程序中所使用的种子URL选择对于有效检索信息非常有用。[7]描述了一种基于用户兴趣本体来进行选择种子URL的新方法。在语义查询的情况下,使用形式概念分析来构造具有用户日志简档的用户兴趣概念格。该用户兴趣本体描述了隐含的概念以及它们之间的关系。通过有效的种子URL选择,爬虫可以生成与搜索查询相关的更有效的结果。

领域工程概念和关键字驱动的爬行与相关性决策机制[8]使用本体概念来提高爬虫性能,此方法还描述了基于关键字搜索条件的URL提取。它提取了包含搜索查询关键字的网页的网址。此方法提高了抓取的准确性,但仅将包含搜索关键字的网页视为相关且不下载其他网页。

垂直搜索引擎[9]的聚焦爬行方法结合了链接和文本分析。该方法通过组合链接和文本分析来检索和索引主题特定文档以此来描述潜在语义索引分类器。 对于链接分析,他们使用概率HITS算法,而对于文本分析,他们使用概率潜在语义索引。

使用相关性上下文图[10]的主题特定爬行的方法侧重于与感兴趣的文档相关的链接。上下文图估计获取的文档与指定主题之间的距离和重要性,并且一般单词分布和主题特定单词分布用于衡量页面和给定主题之间的相关性。

使用多个相关性预测策略[11]用来预测来自爬虫前沿的未访问URL的相关性。此方法使用分层分类法对英语和中文的主题进行跨语言爬行。其中使用四种策略来使用网页内容,即:锚文本,URL地址和链接类型的方案来评估相关性。新的聚焦爬行算法结合了这四种策略和鲨鱼搜索算法。此方法的主要思想是预测URL的相关性以便更好地进行爬网。

另一种同时执行第一次和下一次爬网的方法[12]。下一次爬网从第一次爬网中获取信息以构建一些专家系统。该获取信息包括种子URL,主题关键字,URL预测。这些知识库可以用于构建可学习爬虫的体验,以提供有效的爬行结果。

我们观察到聚焦爬虫使用不同的机制来查找用于爬行的相关页面。但是,大多数抓取工具专注于仅仅只是抓取最顶层的页面。因而在许多情况下,有一些网页与搜索查询相关且未检索。检索这些隐藏和相关的页面可以提高爬行的准确性。本研究探索了检索隐藏和相关页面的可能性。爬行决策包括页面的排名和相关性信息。

三 拟议网页检索模型

所提出的用于垂直搜索引擎的网络爬虫的模型包括页面排名算法和使用潜在语义索引的相似度计算。我们的模型采用中等排名的网页,这些网页在语义上类似于爬网过程的主题查询。所提出方法的架构如图2所示。

- 拟议系统

大多数Web爬网程序都会抓取非常受欢迎且与用户查询相关的页面。爬网应该有效地满足用户的要求,如果爬网无效,用户可能无法获得相关信息。

图二 拟议抓取系统的体系结构

表一:申述

符号 描述

Tmin 页面排名的最小阈值

Tmax 页面排名的最大阈值

U[ ] 排名在tmin和tmax之间的网址列表

P R(p) 页面的页面排名p

P R(v) Tp中每页v的页面排名值

D 阻尼因子

N 总页数

Tp 页面集p指向。

QV 来自p的链接数

tf-idf 术语频率 - 逆文档频率

Dc 文件内容

Aij 术语 - 文档矩阵,其中tf-idf得分表示术语,j表示文档

T 相似性的门槛

L[ ] 要爬网的网址列表

由于大多数抓取工具使用网页排名算法对网页进行排名,因此只会抓取排名较高的网页。使用页面排名算法[4],对于新页面,需要时间来获得高排名并变得流行。在我们的工作中,我们考虑页面的排名和语义相似性。为了提高爬行效率,我们考虑中等排名的页面并且在语义上与给定主题相关。在语义相似性度量中,我们从中等排名页面和页面主题查询中提取文本信息。

我们使用页面排名算法[4]来计算从种子页面提取的每个URL的排名。通过页面排名算法的若干次迭代来计算排名。一旦为所有页面计算了排名,我们就会考虑具有中等排名的页面。表I中给出了所使用的符号的表格表示。设tmin和tmax是用于过滤页面等级的最小和最大阈值。我们考虑在tmin和tmax之间具有相应等级的页面。在算法1中描述了从URL信息中找到页面排名的过程。

- Web内容提取

我们从所有被选中的页面中提取内容。我们还将页面用于主题查询并从每个页面中提取内容。提取的内容存储在文档中,并构建相应的术语-文档矩阵。 我们使用tf-idf算法[13],[14],[15]计算相应文档中每个术语的重要性。 tf-idf值的计算[16]和tf-idf矩阵的构造以算法2的形式表示。

算法2: 计算tf-idf

1 输入:每页的Dc

输出:矩阵Aij

2 阅读每个文档中属于网页的所有术语。

3 计算术语 - 频率为tf(t)=(术语t的计数文件d)/(收集中的术语计数)。

4 计算反向文档频率为idf(t)=(总计文件数/包含的文件数术语t)。

5 计算每个文档中所有术语的tf-idf值。

6 计算tf-idf =TF(t)的IDF(t)的

7 为所有文档构造tf-idf矩阵A.

8 返回Aij

____________________________________________________________________

- 查找页面之间的语义相似性

为了找到页面之间的语义相似性,需要映射文档的上下文。在简单的术语-文档矩阵中,单词上下文太大并且用户发现难以映射上下文。传统的词法匹配也存在同义词和多义词的问题[17]。因此,在多维缩放模型的帮助下,使用最小的上下文或减少空间。在我们的工作中,我们使用潜在语义索引(LSI)[18],这是一种优化的多维缩放模型和基于概念的自动排序技术。 LSI的动机是找到一个有用的术语和文档之间的关系模型[19]。LSI用来确定查询真正隐含的条款。它搜索概念而不是搜索特定单词,并检索与查询相关的文档,尽管该文档不包含查询中的任何单词。在LSI中,每个维度代表集合中的概念。在LSI中,它通过使用接近主成分分析的奇异值分解(SVD)来降低维数。 SVD仅适用于方形矩阵。给定矩阵的SVD表示为:

A = USVT, (1) A表示术语-文档矩阵,U和V是ktimes;r

资料编号:[4788]