从非结构化文本中提取聚类的专业术语外文翻译资料

2021-12-16 23:15:49

英语原文共 9 页

从非结构化文本中提取聚类的专业术语

亚伦bull;格勒

美国芝加哥大学计算研究所

摘要:自动识别相关的专业术语,是理解语言词汇结构所必需的艰巨而重要的任务。 本文利用非结构化文本的共现网络,开发了一种基于语料库的方法,用于提取卫星术语的相干聚类 - 词典边缘的术语。 通过在共生图中提取共同点来识别术语聚类,之后丢弃最大的并且剩余的词在社区内按中心性排序。 该方法在大型语料库中易处理,不需要文档结构和最小规范化。 结果表明,该模型能够在不同大小,内容和结构的语料库中提取连贯的卫星术语组。 调查结果还证实,语言由密集连接的核心(在词典中观察)和词典边缘的系统的,语义连贯的术语组组成。

1 介绍

自然语言由许多关系结构组成,其中许多关系结构可能被词汇特征,区域变异和特定领域惯例所模糊。尽管如此,单词使用的模式表现出松散的语义结构,即邻近单词倾向于相关,这种分布式假设已经以各种方式运作,为关于意义,意图和语言使用的实践和理论问题提供见解和解决方案。分布式分析主要依靠观察自然语言来建立单词,短语和文档的统计表示(Turney和Pantel,2010)。通过学习词典和叙词表,词典和术语研究提出,核心词汇用于定义词汇的剩余部分(Ito和Mester,1995; Mass,2008),虽然许多包含一般语言用法的词汇都存在于这个核心词典中,但即使是最通用的语言也包含专家或所谓的“卫星”词汇。本文介绍了一种利用非结构化文本的共现网络提取这种外围结构的方法。

在词典中观察到核心-边缘结构,其中定义倾向于使用限制词汇,重复使用核心词汇来定义其他词汇(Sinclair,1996; Picard等,2013)。 在词典的更远的区域中,由于大量不常见的单词,使用基于语料库的技术找到系统的语义定义更加困难。不幸的是,词典的边缘可能比核心更重要,因为这是特定领域术语所在的地方-这些特征可能比频繁更重要。

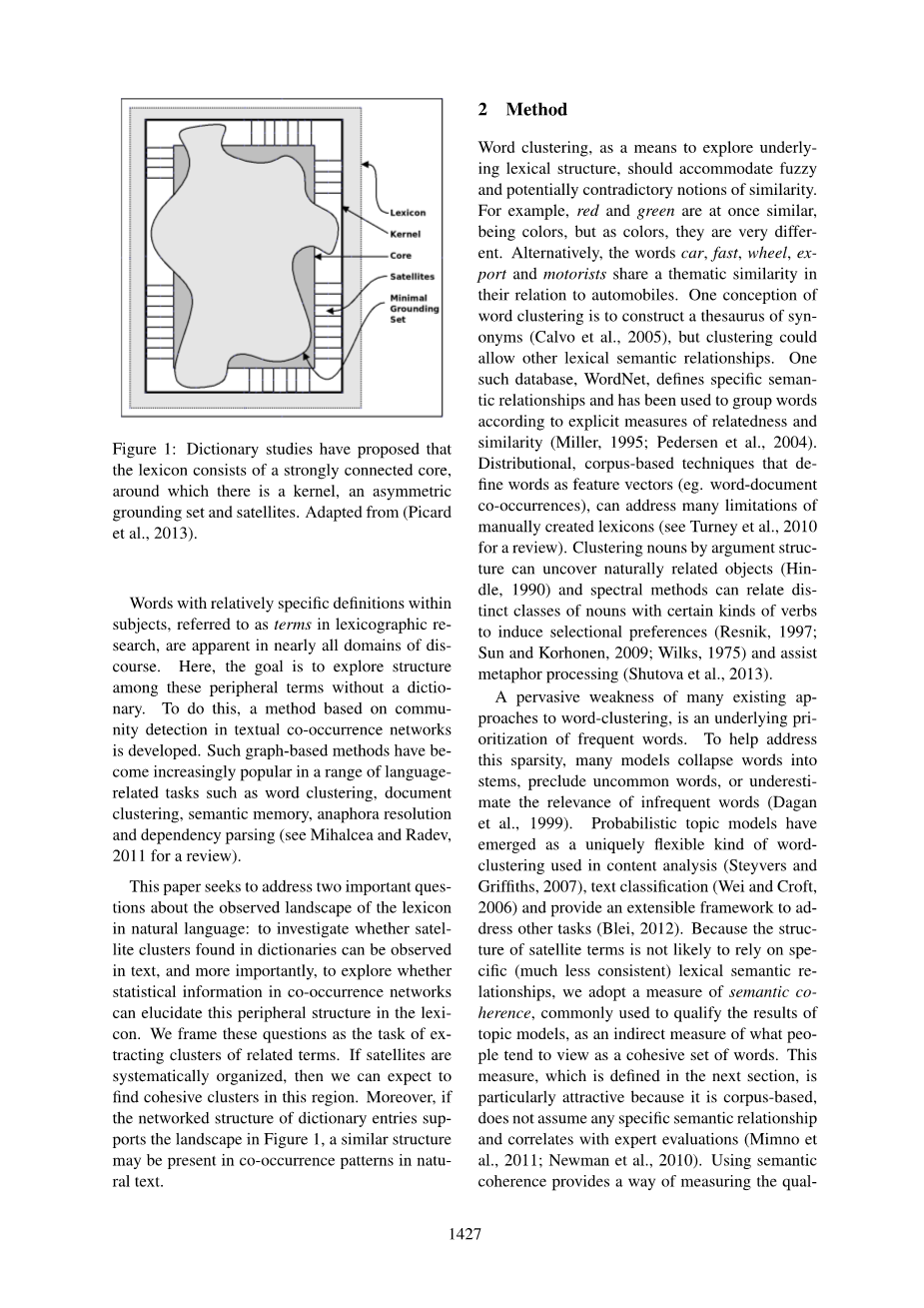

检查字典(Picard等,2013)提出,词典由四个主要部分组成:用于定义其他单词的核心无处不在的单词,构成大部分词典的内核,包含大多数词典的最小接地集核心和一些内核,在外围留下一组卫星,图1中再现的这种地形已经在字典条目使用单词来定义彼此的方式中找到。在字典定义的网络中,核心组件倾向于形成强连接组件(SCC),从而将卫星留在较小的SCC中,并且具有到核心的相对较弱的链路。本文探讨了这些卫星是否形成了系统的,有凝聚力的群体,以及它们是否可以用自然语言观察到。

在主题中具有相对特定定义的词,在词典研究中被称为术语,在几乎所有话语领域都是显而易见的。在这里,目标是在没有字典的情况下探索这些外围术语之间的结构。为此,开发了一种基于文本共现网络中的社区检测的方法。 这种基于图形的方法在一系列与语言相关的任务中变得越来越流行,例如单词聚类,文档聚类,语义记忆,回指解析和依赖性解析(参见Mihalcea和Radev,2011年的综述)。

本文旨在解决关于自然语言中词典观察情况的两个重要问题:调查是否可以在文本中观察词典中发现的卫星聚类,更重要的是,探讨共生网络中的统计信息是否可以阐明这一点。词典中的外围结构。我们将这些问题构建为提取相关术语集群的任务。如果系统地组织卫星,那么我们可以期望在该地区找到有凝聚力的星团。此外,如果字典条目的网络结构支持图1中的格局,则类似的结构可以存在于自然文本中的共现模式中。

2 方法

词汇聚类作为探索潜在词汇结构的手段,应该适应模糊和潜在矛盾的相似概念。例如,红色和绿色同时是相似的,是颜色,但作为颜色,它们是非常不同的。或者,汽车,快速,车轮,出口和驾驶者这两个词在汽车方面具有主题相似性。单词聚类的一个概念是构建同义词的同义词(Calvo等,2005),但聚类可以允许其他词汇语义关系。一个这样的数据库,词汇网定义了特定的语义关系,并已被用于根据相关性和相似性的明确度量对单词进行分组(Miller,1995; Pedersen等,2004)。将单词定义为特征向量(例如,单词 -文档共现)的分布式,基于语料库的技术可以解决手动创建的词典的许多限制(参见Turney等人,2010年的综述)。通过参数结构聚类名词可以揭示自然相关的对象(Hindle,1990),谱方法可以将不同类别的名词与某些类型的动词联系起来以诱导选择偏好(Resnik,1997; Sun和Korhonen,2009; Wilks,1975)并协助隐喻处理(Shutova等,2013)。

许多现有的词汇聚类方法的普遍弱点是频繁词语的潜在优先级。为了帮助解决这种稀疏问题,许多模型将单词翻译成词干,排除了不常见的单词,或低估了不经常单词的相关性(Dagan,1999)。概率主题模型已经成为一种独特灵活的词汇集,用于内容分析(Steyvers和Griffiths,2007),文本分类(Wei和Croft,2006),并提供可扩展的框架来解决其他任务(Blei,2012)。由于卫星术语的结构不太可能依赖于特定的(更不一致的)词汇语义关系,我们采用语义一致性度量,通常用于限定主题模型的结果,作为人们倾向于观察的内容的间接度量作为一组有凝聚力的词汇。该度量在下一节中定义,特别有吸引力,因为它是基于语料库的,不假设任何特定的语义关系并且与专家评估相关(Mimno等,2011; Newman等,2010)。使用语义连贯性提供了一种测量单词关联质量的方法,而不会吸引字典或假设聚类单词之间存在刚性关系。

第一步是构建一个共生图,从中提取社区,然后,在社区内计算每个单词的中心性,以生成特定于群集的排名,目标不是将单词分类为类,也不提供跨语料库分隔关联单词的分区。该方法旨在提取在任意文本中找到的可合格的专家术语集,特别是为了不需要文档结构和最少的预处理:不删除停用词和非词,并且不需要短语,句子或文档结构。虽然词干化或词形还原可以提供更多的流式解释,但是最小的预处理允许该方法在任何语言的大量非结构化文本上有效地操作。

共现网络已经在各种NLP应用中使用,基本思想是构建邻近单词连接的图,通常,如果在n字窗口中观察到,则将此窗口设置为目标两侧的对称7个单词,并且不使用任何加权1。在得到的网络中,边缘频率被设置为观察到给定共现的次数。 由此产生的网络通常非常密集并呈现出小世界结构,其中大多数单词对仅相隔几个边缘(Baronchelli等,2013; Ferror i Cancho和Sole,2001)。为了探索这种密度的影响,测试了不同的最小节点和边缘频率(类似于文本中的单词和共现频率)。结果发现,未设置任何阈值可提供最佳结果(参见图2),支持我们的最小预处理方法。

为了从共生矩阵中提取聚类,使用了Infomap社区检测算法。Infomap是一种信息理论方法,它使用它来优化压缩字典来描述通过连接节点的流量(Rosvall和Bergstrom,2008),通过最小化该流程的描述,该算法还可以提取嵌套社区(Rosvall和Bergstrom,2011)。在我们的实验中,我们使用共生频率作为边缘权重,并且对于算法的每次运行运行50次试验,共生网络倾向于形成一个整体社区,对应于词典的核心SCC,被一些较小的社区所包围,整体社区被排除在右边,因为它代表了很少有专业术语所在的词典的核心。正如我们将看到的,社区检测算法自然地识别该SCC,区分卫星术语集群,虽然我们没有探索其影响,但可以调整Infomap的灵敏度,以改变核心SCC与卫星相比的相对大小,从而有效地将较少模块化的社区视为卫星。

为了比较和解释产生的聚类,测试了各种中心性度量,以便对其社区内的单词进行排序,此排名的目标是找到代表或定义其社区的单词而不假设其基础语义。 下一节的结果表明,许多共同的中心性措施对这项任务的效果相当好,系统的最终输出是一组社区,其中的单词按其中心性排名。

3 结果与分析

三个语料库用于评估:TASA,NIPS和enTenTen馆藏。TASA包括段落长度的高中级摘录,美国英语文本(Landauer和Dumais,1997),NIPS系列包含来自同名会议的17卷年度会议记录,enTenTen语料库是一个基于Web的文本密集的英语网站集合。 表1总结了馆藏及其共现网络。

提取的社区由单词中心对组成,其结构类似于主题模型的输出。因为对人类判断的诉求是昂贵的并且可以引入一致性问题(Chang等人,2009; Hu等人,2011),已经提出了基于语料库的语义一致性度量(Mimno等人,2011)。连贯性被用作人类判断的代理,语义一致性的一般形式可以定义为主题中前n个单词的平均成对相似度,纽曼等人调查了一些相似性指标,发现平均点相互信息(PMI)与人类判断相关性最好。与独立贡献相比,PMI是一种常用的衡量共同发生的信息共同传达的方法(Church 和Hanks,1990; Bouma,2009),使用PMI作为S,我们可以定义一致性的版本,称为UCI 相关性:

其中p(omega;)被估计为语料库中的相对频率:使用一致性来优化主题模型,Mimno等(2011)发现简化的度量,称为UMass 相关性,与CUCI相比,与人类判断的关联性更强。 对于主题t,定义如下:

其中D(omega;)是包含omega;的文档的数量,D(omega;,omega;0)是包含omega;和omega;0的文档的数量。注意,D主要依赖于参考语料库中的文档分段,其不在由上述方法导出的同现网络中编码,因此,尽管被分析的网络和相干性得分都是基于共现信息,但它们彼此不同。遵循惯例,我们计算给定社区中前10个单词的一致性。 CUMass被用作语义连贯性的度量,并且在TASA语料库上计算D,这意味着得到的分数不能与(Mimno等人,2011)直接比较,尽管下面提供了与其他公布结果的比较。

3.1排名函数和频率阈值

在从共生图中提取社区之后,按照社区中的中心性对单词进行排名,测试六个中心度量作为排名函数:度中心性,亲密度中心性,特征向量中心性,Pagerank,中心得分和权威得分(Friedl等,2010)。在高度连接的节点是中心的假设下,度中心性使用节点度作为其中心性,紧密度中心度衡量节点与所有其他节点之间的平均距离,从而促进与网络其余部分“接近”的节点,特征向量中心性有利于连接良好的节点,这些节点本身连接到连接良好的节点。 Pagerank类似于特征向量中心性,但也促进了调解强连接节点之间连接的节点,集线器和权限分数衡量互连性(集线器)和互连节点(权限)的连通性。图2显示了对于每个中心度量,从TASA语料库中提取的所有社区的平均一致性,使用中心得分,平均一致性得分最高,但并不比auth-score,特征向量中心性或亲密度中心性显着更好。在随后的结果中,hub-score用于对社区内的节点进行排名。

还测试了在共现图中施加最小节点和边缘频率,但是,不应用阈值可提供最高的平均一致性。图3显示了八种阈值配置的平均相干性,虽然我们使用TASA语料库进行这些测试,但我们没有理由相信其他语料库的结果会有很大差异。

3.2社区一致性

表2显示了从每个文本集合中提取的三个专家术语社区,以及它们的标准化轮询分数。规范化分数可以保持其排名顺序,并提供社区内部相对中心性的指示。例如,比较顶级TASA和NIPS集群中的第一个和最后一个单词:though和craven之间的差异(TASA)远远超过模型和网络(NIPS)。一般而言,排名较高的单词似乎代表了他们的社区,在NIPS示例中使用了模型,大学和核等词,这些聚类是该方法产生的典型聚类,但在某些情况下,社区包含的术语少于10个,并且不包括在一致性分析中。请注意,这些集群在任何词汇语义意义上都不具有系统性,尽管几乎在每种情况下都存在可辨别的主题关系(中英文单词,拉丁美洲和TASA中的海鲜)。

图4显示了我们的方法的平均相干性,与20个主题的潜在Dirichlet分配(LDA)模型相比,适用于相同的语料库。 LDA模型的结果与我们的语料库以及已发表主题的样本一致,作为基线来提供,以校准读者对相干性的直觉判断。虽然来自LDA的主题不一定由当前模型中的专家术语组成,但仍然存在一致性的期望:可能或中心词应该包括一个有凝聚力的群体。在每种情况下,对于每个10个或更多单词的社区,使用社区内部分数排名的前10个单词计算一致性。结果表明,LDA提供了跨集合的相对一致的一致性,尽管通常比专业术语的社区更多的差异;对于enTenTen集合而言,集群一词比其他集群更为一致,这可能是由于其更大的规模,对最大语料库的这种上升可能与enTenTen中结构较少的文档的整体社区的比例大小有关。图5描述了核心的比例大小如何影响卫星星团的数量和大小,结果发现,最大的社区(核心SCC)包括95%的TASA,90%的NIPS和97%的enTenTen。专业语言可能会有一个比例较小的核心和更多的卫星社区,而更通用的语言将拥有更大的核心和更少的卫星。

关于该方法是否实际观察词典的核心-外围结构或者它是否是人工制品,仍然存在一个关键问题。为了测试这一点,将卫星社区中的单词频率与整体情况下的单词频率进行了比较,如果整体社区确实对应于图1中提出的核心,则卫星中的字应该具有明显更低的频率。实际上,每个语料库中的整体社区包含的语言比社区中的语言更为频繁(Wilcoxon秩和检验;表3)。采用相干性得分,这些结果表明词汇周边存在连贯的结构,可以从非结构化文本中提取。

4 讨论

我们的方法的结果表明,词典中的外围结构可以直接从大量非结构化文本中提取。先前在字典研究中探索过的词典地形包含可观察的模块化卫星术语组,不会吸引外部资源或文档结构,并且标准化程度最低。这种方法的贡献是双重的:它证实了观察词典的结构类似于字典组织中的结构(Picard等,2013)。其次,它提供了一种易于处理,可靠的方法来提取和总结词典边缘的结构。

这里开发的模型的输出类似于主题模型,但有一些重要的差异。主题模型在单词上产生概率分布以定义主题,可以通过前10到20个最可能的单词来概括。而不是概率,社区内部分数用于对每个群集中的单词进行排名。这意味着社区的实际结构(主题不

资料编号:[4785]