走向互联虚拟现实:机遇、挑战和促成因素外文翻译资料

2022-08-10 19:35:35

英语原文共 8 页,剩余内容已隐藏,支付完成后下载完整资料

走向互联虚拟现实:机遇、挑战和促成因素

摘要

就在最近,无线增强虚拟现实(AR/VR)的概念席卷了整个5G生态系统,引起了学术界、工业界和其他方面前所未有的兴趣。然而,身临其境的虚拟现实体验的成功依赖于跨越多个学科的大量重大挑战的解决。本文强调了虚拟现实技术作为5G(及更高版本)的破坏性用例的重要性,它利用了存储/内存、雾/边缘计算、计算机视觉、人工智能等领域的最新发展。特别地,本文描述了无线互联虚拟现实的主要需求,选择了关键的使能技术并提出了研究途径和潜在的巨大挑战。此外,我们检视三个虚拟现实案例,并提供不同储存、计算和网路配置下的数值结果。最后,本文揭示了当前网络的局限性,提出了更多的理论和创新,为大众提供虚拟现实技术的先锋。

介绍

利用存储/内存、通信/连接性、计算、大数据分析、人工智能(AI)、机器视觉和其他辅助领域的最新进展的介绍,将有助于实现类似于增强和虚拟现实(AR/VR)等沉浸式技术。这些技术将使超高分辨率的光和声音能够通过其各种视觉、声音和情感的传递实时地传送到另一个世界。虚拟现实的使用将超越游戏等早期使用者,而提升网络物理和社交体验,如与家人和熟人交谈、商务会议和残疾人。想象一下,如果一个人能戴上虚拟现实耳机,在一条人人都在说芬兰语的街道上走来走去,在一个完全沉浸式的体验中与讲芬兰语的人交流。除此之外,越来越多的无人驾驶飞机、机器人和其他自动驾驶车辆将摄像机带到人类无法想象的地方;我们将从一个有趣的全球视角看到新内容的快速增长。最终,虚拟现实将提供最接近屏幕的个人体验,提供迄今为止所见的最紧密、最沉浸的体验。

AR和VR代表频谱的两端。一方面,AR是以现实为主要焦点,虚拟信息呈现在现实之上,而VR则是以虚拟数据为主要焦点,将用户沉浸在合成现实虚拟环境的中间。我们还可以想象一个混合的现实,AR与VR通过无缝地融合物理和虚拟信息。当前的在线社交网站(Facebook、Twitter等)正是我们将真正见证的社交网络包含沉浸式虚拟现实技术的先兆。最基本的是,社交虚拟现实允许两个地理上分离的人(以化身的形式)像面对面一样进行交流。他们可以进行眼神交流,也可以操纵他们都能看到的虚拟物体。目前的虚拟现实技术刚刚起步,耳机还不能准确地追踪眼睛的指向,而是通过观察与之交谈的人。此外,目前最先进的虚拟现实技术还无法读取详细的面部表情和感官。最后,也许是一个最大的警告,就是最强大的虚拟现实原型是用电缆连接的,因为高帧速率下传输的高分辨率视频数量根本无法用当今的无线技术(4G/LTE)完成,更不用说一个完美的用户界面(相当于鼠标的虚拟现实)还在制作中。

这些缺点推动人们不断努力为在不久的将来实现社会虚拟现实。林登实验室(一个基于屏幕的模拟)是众多初创公司中的一家,它正准备推出一个名为SANSAR[1]的新平台,该平台是用户创建虚拟体验和工具的主机以及用于虚拟现实耳机、标准计算机显示器和移动设备。类似地,SANSAR世界的功能将与Second Life非常相似,人们会为他们的虚拟创作租用空间,以3D格式和高帧速渲染。同样,BELOOLA[2]正在构建一个为社交网络设计的虚拟世界。这些最近的趋势清楚地表明,响应式媒体的时代已经来临,在这个时代,媒体制作者将动态地调整内容,以符合消费者的注意力、参与度和情况。虽然一些虚拟现实技术(虚拟现实护目镜、情感感应算法和多摄像头系统)已经出现,但目前的第四代(4G)(甚至5G之前的)无线系统无法满足虚拟现实的大量带宽和延迟要求。

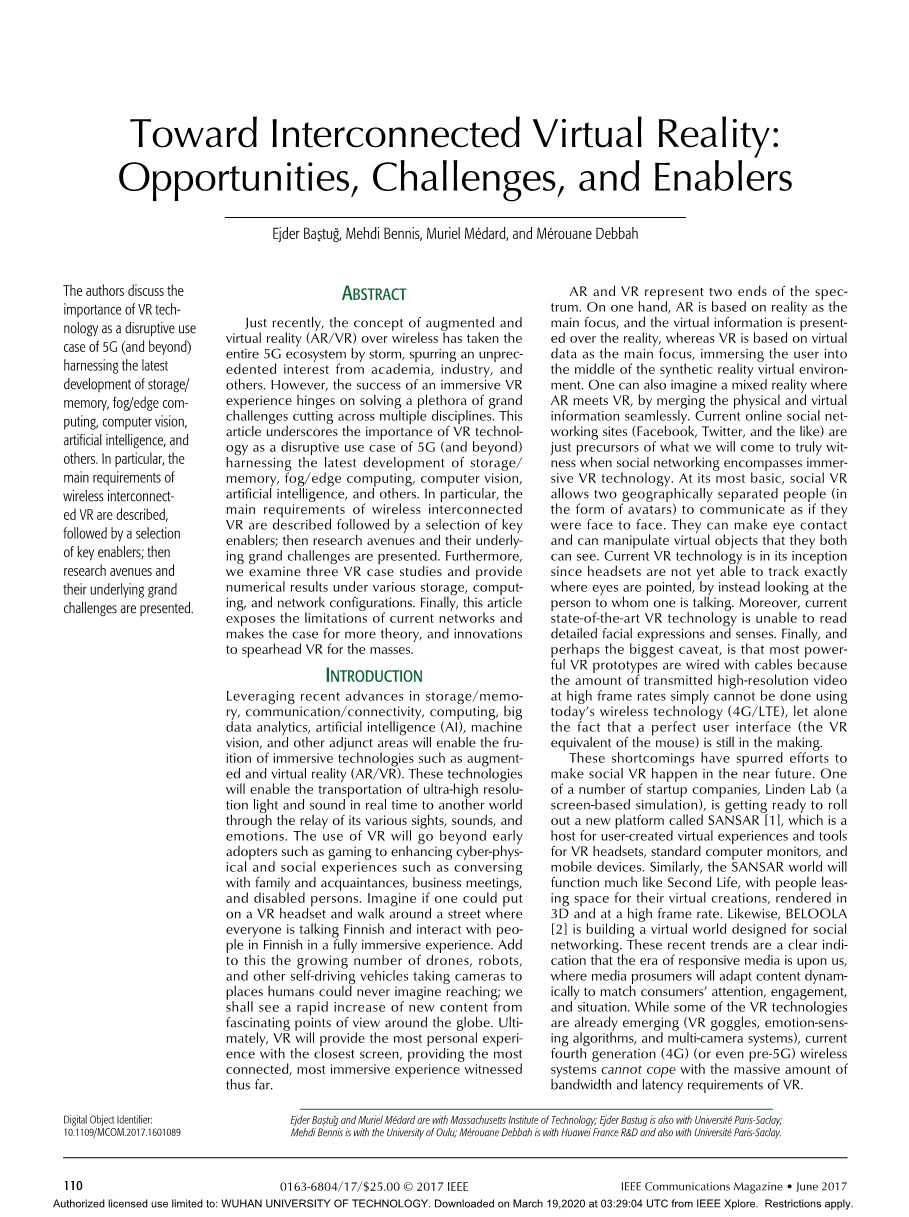

图1 虚拟现实场景的说明:a)当前的虚拟现实系统;b)互连;c)理想(完全互连)系统。

本文旨在探讨虚拟现实系统的发展趋势,以期达到一个完全互联的虚拟现实世界。根据设想,虚拟现实系统将经历三个不同的发展阶段,如图1所示,从目前的虚拟现实系统开始,向互联虚拟现实(IVR)发展,最终形成理想的虚拟现实系统。本文的其余部分将专门讨论这一演变,并为最终的虚拟现实技术提供一些关键的实现方法和要求。在这方面,我们讨论了当前的虚拟现实系统和人类在转向互联虚拟现实和相关技术要求之前的感知极限。然后详细介绍了关键的研究途径和科学挑战。最后给出了几个算例分析。最后,我们讨论是否可以实现一个理想的完全互连的虚拟现实系统,以及在这方面可能需要什么。

对于互连的虚拟现实

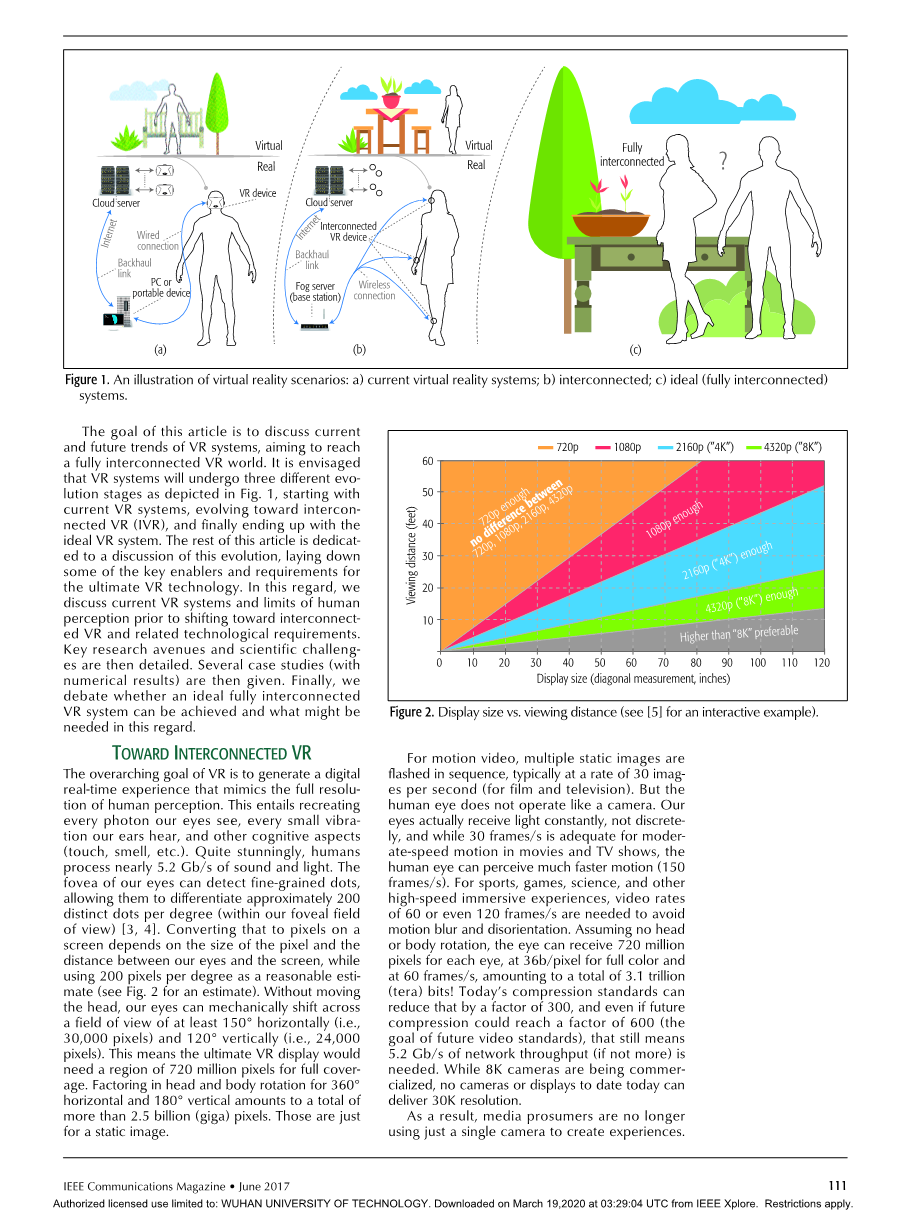

虚拟现实的首要目标是产生一种数字实时体验,模仿人类感知的完全分辨率。这需要重现我们眼睛看到的每一个光子,我们耳朵听到的每一个小振动,以及其他认知方面(触觉、嗅觉等)。相当惊人的是,人类处理近5.2 Gb/s的声音和光。我们的眼睛中央凹可以探测到细粒度的点,使它们每度能分辨出大约200个不同的点(在我们的中央凹视场内)[3,4]。将其转换为屏幕上的像素取决于像素的大小和眼睛与屏幕之间的距离,同时使用每度200像素作为合理的估计值(估计值见图2)。在不移动头部的情况下,我们的眼睛可以机械地在至少150°水平(即30000像素)和120°垂直(即24000像素)的视野中移动。这意味着最终的虚拟现实显示需要7.2亿像素的区域才能实现全覆盖。考虑到360°水平和180°垂直的头部和身体旋转,总共超过25亿(千兆)像素。这些只是静态图像。

图2 显示大小与观看距离(有关交互示例,请参见[5])

对于运动视频,多个静态图像按顺序闪烁,通常以每秒30个图像的速率(对于电影和电视)。但人眼的运作不像照相机。我们的眼睛实际上是不断地接受光线,而不是离散地,虽然30帧/秒足以在电影和电视节目中进行中速运动,但人眼可以感知更快的运动(150帧/秒)。对于运动、游戏、科学和其他高速沉浸式体验,需要60帧甚至120帧/秒的视频速率,以避免运动模糊和迷失方向。假设没有头部或身体旋转,眼睛每只眼睛可以接收7.2亿像素,全彩为36b/像素,60帧/秒,总计3.1万亿比特!现在的压缩标准可以将其减少300倍,即使未来的压缩可以达到600倍(未来视频标准的目标),这仍然意味着需要5.2 Gb/s的网络吞吐量(如果不是更多)。虽然8K相机正在商业化,但迄今为止,没有相机或显示器能提供30K分辨率。

图3 互联虚拟现实的研究途径与科学挑战

因此,媒体散户不再仅仅使用一个摄像头来创造体验。以今天的4K分辨率、30帧/秒和24 b/像素,并使用300:1的压缩比,可以产生300 Mb/s的图像。这是一个高质量4K电影体验的典型要求。当全景摄影机装备面向外部时,还有另一种系统,即摄影机面向内部以捕捉实时事件。例如,今年的超级碗就有70个摄像头,其中36个摄像头专门用于一种新型的拍摄系统,可以在观众围绕动作中心盘旋时冻结动作。以前,这类效果只有在电子游戏中才可能实现,因为它们需要大量计算才能将多个视图缝合在一起。重型后处理意味着在实战中无法获得此类效果。因此,5G网络架构被设计为将后处理移动到网络边缘,以便边缘处理器和客户端显示设备(虚拟现实护目镜、智能电视、平板电脑和电话)执行高级图像处理,将相机馈送缝合成戏剧效果。为了详细说明当前网络的背景,即使有十几个摄像头拍摄一个场景,今天的观众一次只能看到一个视图。因此,带宽需求不足以提供所有相机馈送的集合。为了解决这个问题,动态缓存和多播可以通过从一个提要向数千个提要发送内容来帮助减轻负载。与以用户设备(UE)为中心的道路类似,VR将让观众动态地选择他们各自的观点。这意味着来自所有摄像机的馈送需要立即同时可用,这意味着当每个观众成员选择个性化视点(单播)时,传统的多播将不可能实现。这会引起停机和用户的不满。

技术要求

为了应对这些重大挑战,5G网络架构(无线接入网络[RAN]、edge和core)将需要比以往任何时候都更加智能,通过自适应和动态地利用诸如软件定义网络(SDN)、网络功能虚拟化(NFV)和网络切片等概念,举几个例子,它可以更灵活地分配资源(资源块、访问点、存储、内存、计算等),以满足这些需求。与此同时,视频/音频压缩技术正在开发中,以便为新的多摄像机系统实现更高的压缩比。传统的视频压缩利用图像在一帧和下一帧之间的相似性(时间冗余),而虚拟现实压缩则增加了这种相似性,并利用了来自不同摄像机(包括天空、树木、大型建筑物和其他摄像机)的图像之间的相似性,称为空间冗余),并使用智能切片和平铺技术,使用较少的带宽来提供完整的360°视频体验。所有这些进展可能仍然不足以达到完全沉浸式体验的理论极限。最终,迫切需要一种全新的网络体系结构,能够动态地多播和缓存靠近消费者的多个视频源,并在网络中执行高级视频处理以构建个性化视图。

商业技术需要这些技术在带宽、延迟和可靠性方面的巨大改进。当前的远程现实原型(MirrorSys[6])需要100-200 Mb/s的速度才能获得单向沉浸式体验。虽然MirrorSys使用一个8K,但在照片真实感虚拟现实中估计需要两个16Ktimes;16K屏幕(每只眼睛一个)。延迟是除了可靠性之外的另一个大问题。例如,对于AR耳机,实际的视觉和听觉信息必须通过摄像头发送到雾/云进行处理,数字信息被发送回来,精确地覆盖到真实环境中,所有这些都必须在比人类开始注意滞后(不超过13毫秒[7])所需的时间更短的时间内发生。在这些带宽和延迟要求的基础上,考虑到迫切需要的高可靠性标准,这清楚地表明了几个研究学科之间需要相互作用。下面讨论这些研究途径。

关键研究和科学挑战

互连虚拟现实的成功取决于解决跨网络和设备的大量研究和科学挑战,这些设备具有异构的存储、计算、视觉、通信和上下文感知能力。这些关键的研究方向和科学挑战总结在图3中,讨论如下。

缓存/存储/内存

最近对内容缓存的概念进行了详细的研究[8],其思想是在网络边缘(在基站[BS]、设备或其他中间位置)缓存战略性内容。一种是区分反应式缓存和主动式缓存。前者在最终用户请求内容时为其提供服务,后者则是主动的,并预测用户的请求。主动缓存依赖于细粒度时空流量预测的可用性。另一边的信息,如用户的位置、移动模式和社会联系,特别是在上下文信息稀疏的情况下,可以被进一步利用。在虚拟现实中,存储将起着至关重要的作用。例如,当任务查询到达时,网络/服务器需要快速决定是否存储对象(如果同一请求将在不久的将来到达),或者如果查询的到达率在不久的将来是稀疏的,则需要从头开始重新计算查询。内容/媒体放置和交付对于在不同网络位置存储相同内容的不同质量也很重要[9,10]。

本地/雾/边缘/云计算和处理

将计算密集型任务从虚拟现实设备迁移到资源更丰富的云/雾服务器是必要的,以提高低成本设备的计算能力,同时节省电池能源。为此,移动边缘计算(MEC)将使设备能够按需访问云/雾资源(基础设施、平台和软件)。虽然当前最先进的解决方案以集中的方式(在云上)分配无线和计算资源,但对于虚拟现实,必须通过利用密集的小蜂窝基站的可用性(接近计算/存储/内存资源),使无线接入和计算资源更接近虚拟现实用户。此外,网络基础设施必须能够实现完全分布式的云沉浸式体验,其中大量计算发生在云/边缘的非常强大的服务器上,同时共享客户端终端用户设备交付的传感器数据。在最极端的情况下,人们可以考虑在非常局部的层次上进行计算,例如在人体中完全/部分嵌入设备时,具有计算能力。这种现象通常被称为“皮肤计算”。

短距离无线通信

利用短距离通信(如设备到设备(D2D)和边缘邻近服务)在并置的虚拟现实用户之间进行的短距离无线通信有助于缓解网络拥塞。其思想是在虚拟现实用户之间提取、缝合和共享视图和相机馈送方面的相关上下文信息。在配备超高清晰度(UHD)摄像头的自动驾驶车辆捕获其本地邻域的背景下,车辆/机器人的任务不仅是实时识别对象/人脸,而且还决定哪些对象应包含在地图中,并与附近的车辆共享,以获得更丰富和更具上下文感知的地图。

计算机视觉和媒体

超高清摄像机(8K,360°全景视频的新摄像机)的出现丰富了新的视频和媒体体验。同时,今天的媒体内容处于两个极端。一方面,它区分了电影和电视等“向后倾斜的体验”,在这种体验中,消费者是被动的,由内容作者/制作人通过故事引导。另一方面是以游戏形式的“向前倾斜”体验,用户高度参与其中,并通过内容作者/制作人创建的环境来推动行动。下一代“互动媒体”将根据观众和最终用户的情况和偏好,动态调整作者/制作人的叙事方式。

上下文信息和分析

上下文信息的使用已经被提倡作为优化复杂网络的一种手段。通常,上下文信息是指设备内部和网络内部的信息(用户位置、速度、电池电量和其他介质访问控制[MAC]/高层方面)。在虚拟现实的背景下,苹果最近收购了Emotient公司,这家公司使用先进的计算机视觉来识别人们的情绪,这清楚地表明,环境信息将在虚拟现实的成功中发挥越来越重要的作用。为了最大化用户的连接和身临其境的体验,

用户行为数据和社交虚拟现实

多个屏幕激增的副产品是,切换概念更为普遍,用户的注意力从一个屏幕转移到另一个屏幕。必须考虑基于用户行为数据和社交互动的新解决方案,以解决用户的易变性。为此,切换和屏幕混沌问题的答案基本相同。沉浸式体验是一种集成的体验,它需要一个数据驱动的框架,该框架将一个人看到的所有有用信息带到一个地方。今天,由于没有共同的平台,这种集成不会发生。虚拟现实要求所有这些经历都发生在一个地方。如果一个人在看电影或玩游戏时接到电话,游戏(或电影)会自动暂停,而此人不必考虑暂停电影和接听电话。考虑到一个共同的数据驱动平台正在形成,大数据和机器学习工具将在为用户带来沉浸式体验方面发挥关键作用。

科学的挑战

这一节的目标是奠定了基础的VR,为了VR的成功突出重点不同的研究议程和潜在的解决方案的概念。

需要一个“香农式”理论:对于一个给定的虚拟现实设备,S位存储、E焦耳能量和C赫兹处理能力,我们如何最大限度地提高用户的沉浸式体验,或者减少虚拟现实用户的易变性?答案取决于许多参数,如虚拟现实设备服务器空中链路、虚拟现实设备是人还是机器人、网络拥塞、虚拟现实处理、虚拟现实成本(虚拟现实耳机能提供多少

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[237997],资料为PDF文档或Word文档,PDF文档可免费转换为Word