Complex-YOLO:用于点云上实时3D对象检测的欧拉区域提议网络外文翻译资料

2022-08-09 10:52:46

英语原文共 14 页,剩余内容已隐藏,支付完成后下载完整资料

Complex-YOLO:用于点云上实时3D对象检测的欧拉区域提议网络

马丁·西蒙,斯特凡·米尔兹,卡尔·阿蒙德,霍斯特·迈克尔·格罗斯

伊尔默瑙工业大学法雷奥沙尔特与传感器有限公司

martin.simon,stefan.milz,karl.amende}@valeo.comhorst-michael.gross@tu-ilmenau.de

摘要

基于激光雷达的3D对象检测对于自动驾驶是不可避免的,因为它直接链接到对环境的了解,因此为预测和运动计划奠定了基础。实时推断高度稀疏的3D数据的能力是除自动驾驶汽车之外的许多其他应用领域的不适定问题,例如增强现实,个人机器人或工业自动化。我们介绍了Complex-YOLO,这是仅在点云上的最先进的实时3D对象检测网络。在这项工作中,我们描述了一种网络,该网络通过特定的复杂回归策略来扩展笛卡尔空间中的多类3D框,从而扩展RGB图像的快速2D标准对象检测器YOLOv2。因此,我们提出了一个特定的Euler-RegionProposal网络(E-RPN),通过向回归网络添加虚部和实部来估计对象的姿态。这最终会在封闭的复杂空间中发生,并避免了单角度估计所产生的奇异性。E-RPN支持在培训过程中很好地概括。我们在KITTI基准套件上进行的实验表明, 就效率而言,我们的性能优于目前领先的3D对象检测方法。我们比最快的竞争对手快五倍以上,从而为汽车,行人和骑自行车的人带来了最先进的成绩。此外,我们的模型能够高精度地同时估算所有八个KITTI类,包括货车,卡车或行人。

关键词:3D对象检测,点云处理,激光雷达,自动驾驶

1介绍

由于近年来汽车激光雷达传感器的强劲改进,点云处理对于自动驾驶正 变得越来越重要。供应商的传感器能够实时交付周围环境的3D点。优点 是可以直接测量包围对象的距离。这使我们能够开发用于自动驾驶的物体检测算法,该算法可准确估算3D中不同物体的位置和方向。与图像相比,激光雷达点云稀疏,并且密度分布在各处。

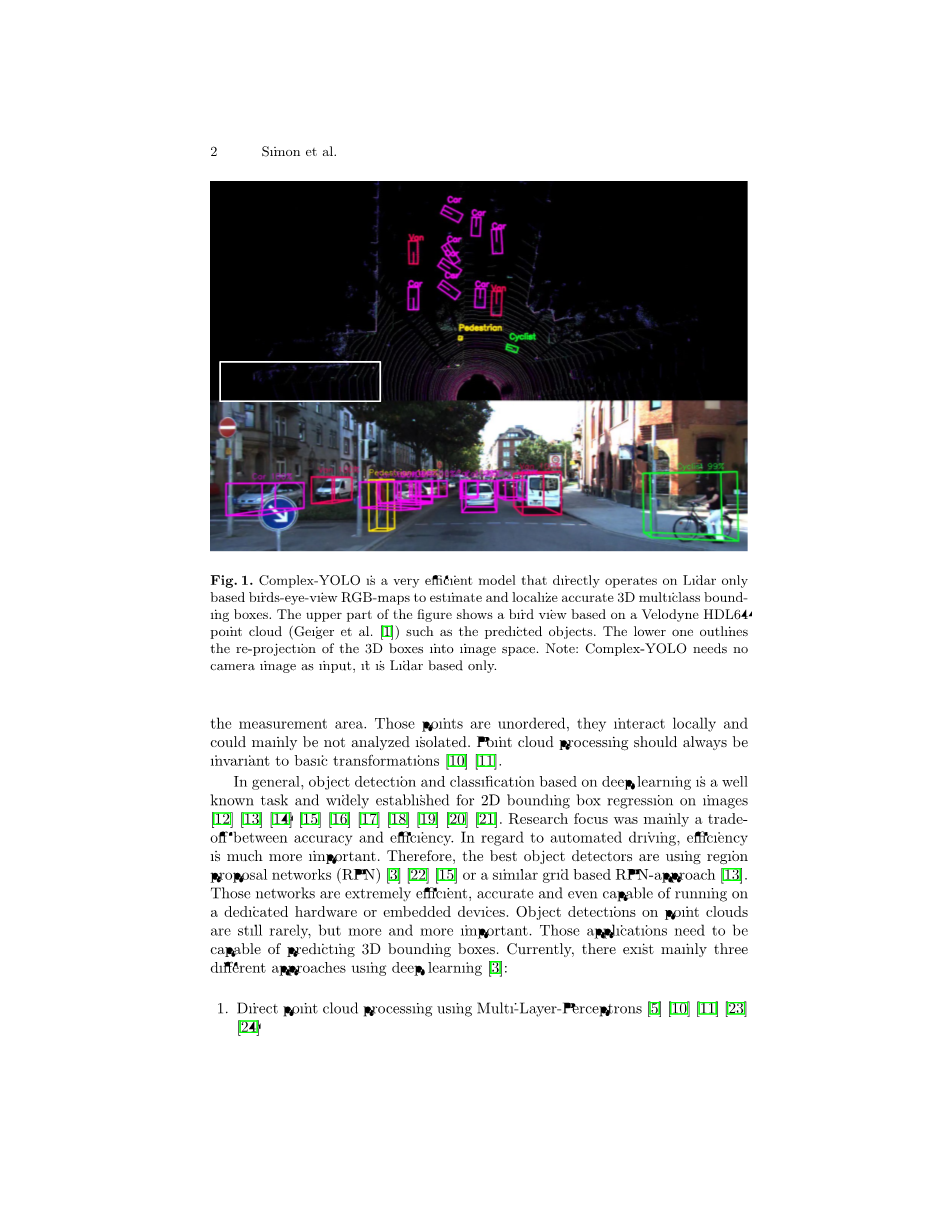

图1. Complex-YOLO模型

Complex-YOLO是一种非常有效的模型,可以直接在仅基于Lidar的鸟瞰RGB贴图上运行,以估计和定位准确的3D多类边界框。该图的上部显示了基于VelodyneHDL64点云的鸟瞰图(Geiger等人。[1])例如预测对象。下部的轮廓概述了3D框在图像空间中的重新投影。注意:Complex-YOLO不需要摄像机图像作为输入,它仅基于激光雷达。

测量区域的点是无序的,它们在本地相互作用,并且可能主要不能孤立地进行分析。点云处理应始终不变于基本转换通常,基于深度学习的对象检测和分类是一项众所周知的任务,已广泛用于图像的2D边界框回归. 研究重点主要是准确性和效率之间的权衡。对于自动驾驶,效率更为重要。 因此,最好的物体检测器正在使用区域提议网络(RPN) 或类似的基于网格的RPN方法[13].这些网络非常高效,准确,甚至可以在专用硬件或嵌入式设备上运行。点云上的对象检测仍然很少,但是越来越重要。这些应用程序必须能够预测3D边界框。当前,主要存在三种使用深度学习的方法:

1、使用多层感知器的直接点云处理

2、使用卷积神经网络(CNN)将点云转换为体素或图像堆栈组合

3、使用融合方法相关工作

1.1准备工作

最近,基于视锥的网络已在KITTIBenchmark套件上显示出高性能。模特排名其次是3D对象检测,例如基于汽车,行人和骑自行车者的鸟瞰检测。这是唯一使用Point-Net直接处理点云的方法无需在激光雷达数据和体素创建上使用CNN。但是,它需要进行预处理,因此也必须使用相机传感器。基于另一个处理已校准摄像机图像的CNN, 它使用这些检测将全局点云最小化为基于视锥的还原点云。这种方法有两个缺点:

1、模型的准确性很大程度上取决于摄像机图像及其相关的CNN。因此,不可能仅将该方法应用于激光雷达数据。

2、整个流程必须连续运行两种深度学习方法,从而导致推理时间更长, 效率更低。所引用的模型在NVIDIAGTX1080iGPU上以大约7fps的太低帧速率运行。

相反,Zhou等。提出了仅对激光雷达数据起作用的模型。关于这一点,它是仅使用激光雷达数据进行3D和鸟瞰检测时在KITTI上排 名最高的模型。基本思想是在不使用手工功能的情况下在网格单元上运行的端到端学习。使用Pointnet方法在训练期间学习网格单元内部 特征。在顶部建立一个可预测3D边界框的CNN。尽管精度很高,但模型在TitanXGPU上的推理时间仅为4fps.

Chen等报道了另一种高度评价的方法。基本思想是使用手工制作的功能(例如点密度,最大高度和代表性点强度)将激光雷达点云投影到基于体素的RGB贴图中。为了获得高度准确的结果,他们使用了基于Lidar鸟瞰图,基于Lidar的前视图和基于相机的前视图图像的 多视图方法。这种融合最终导致处理时间延长, 而在NVIDIAGTX 1080iGPU上仅产生4fps。另一个缺点是需要辅助传感器输入(摄像机)。

1.2贡献

令我们惊讶的是,到目前为止,还没有人在自动驾驶方面实现实时效率。 因此,我们推出了第一个纤薄而精确的模型,该模型在NVIDIATitanX GPU上的运行速度高于50fps。我们使用多视图想法(MV3D)[5] 用于点云预处理和特征提取。但是,我们忽略了多视图融合,只生成了一个单眼鸟瞰RGB贴图(见图。1)仅基于激光雷达,以确保效率。

最重要的是,我们展示了3D版本YOLOv2的Complex-YOLO,这是最快的最新图像对象检测器之一[13].Complex-YOLO由我们的特定E-RPN支持, 该E-RPN估计每个盒子的虚部和实部编码的对象的方向。这个想法是要有一个封闭的数学空间而没有奇异点,以实现精确的角度泛化。即 使对象是基于几个点(例如,行人),我们的模型也能够实时预测具 有定位的精确3D框和对象的精确方向。因此,我们设计了特殊的锚盒。此外,它仅通过使用激光雷达输入数据就可以预测所有八个KITTI类。 我们在KITTI基准套件上评估了我们的模型。在准确性方面,我们在汽车,行人和骑自行车者方面均取得了同等的成绩,在效率方面,我 们的表现优于现任领导人至少5倍。

本文的主要贡献是:

1、这项工作通过使用新的E-RPN为3D盒估计提供可靠的角度回归功能, 介绍了Complex-YOLO。

2、我们提供了在KITTI基准套件上评估的高精度实时性能,其速度是 当前领先型号的五倍以上。

3、我们估计E-RPN支持的每个3D框的精确航向,从而能够预测周围物体的轨迹。

4、与其他基于激光雷达的方法相比(例如[3])我们的模型在一条前进路径中同时有效地估计所有类。

2综合体

本节介绍了基于网格的点云预处理,特定的网络体系结构,派生的损失 函数进行训练以及我们为确保实时性能而进行的效率设计。

2.1点云预处理

VelodyneHDL64激光扫描仪获取的单帧3D点云[1],转换为一张鸟瞰RGB贴图,覆盖80mx40m的区域(请参见图4)直接在传感器原点的前面。受Chen等人启发。(MV3D)[5], RGB贴图由高度,强度和密度编码。网格图的大小定义为n= 1024和m=512。因此,我们将3D点云投影并离散化为分辨率约为g= 8cm的2D网格。与MV3D相比,我们略微减小了像元大小,以实现更少的量化误差,同时具有更高的输入分辨率。由于效率和性能原因,我们仅使用一个而不是多个高度图。因此,所有三个特征通道(zr, zg,zb对覆盖区域Omega;内的整个点云Pisin;R3计算zr,g,bisin;Rmtimes;n)。我们考虑Velodyne在PΩ的原点内,并定义:

PΩ={P =[x,y,z]T|xisin;[0,40m],yisin;[minus;40m,40m],zisin;[minus;2m,1.25m]}

图2. Complex-YOLO管道

我们提出了一条苗条的管道,可以对点云进行快速而准确的3D框估计。RGB映射被馈送到CNN中

1、 E-RPN网格在最后一个特征图上同时运行,并预测每个网格单元有五个框。每个盒子 预测都由回归参数t组成。

2、物体得分p的概率一般为p0,n类得分的概率为p1 ... pn。

考虑到激光雷达z位置1.73m,我们选择z [2m,1.25m][1],覆盖地面上方约3m高的区域,期望卡车是最高的物体。借助校准,我们定义一个映射函数

Sj=fps(PΩi,g),其中Sisin;Rmtimes;n将具有索引i的每个点映射到我们的RGB映射的特定网格单元j中。一个集合描述了映射到特定网格单元中的所有点

PΩi→j={PΩi=[x,y,z]T|Sj=fps(PΩi,g)} (2)

因此,我们可以将Velodyne强度视为I(PΩ)来计算每个像素的通道:

zg( Sj) =max(PΩ·[0, 0, 1]T)

zb(Sj)=max(I(PΩi→j)) (3)

zr(Sj)=min(1.0,log(N 1)/64)

N=|PΩi→j|

在此,N描述了从PΩi映射到Sj的点数,而g是网格单元大小的参数。因此, zg编码最大高度,zb最大强度编码,zr映射到j的所有点的归一化密度S

2.2建筑

Complex-YOLO网络拍摄鸟瞰RGB贴图(请参阅“2.1)作为输入。它使用简化的YOLOv2[13] CNN体系结构(请参见标签。1), 通过复杂的角度回归和E-

RPN扩展,可在仍实时运行的情况下检测准确的面向多类的3D对象。

欧拉区域提案:我们的E-RPN解析3D位置bx,y,对象尺寸(宽度bw和长度bl) 以及概率P0,类分数P1...Pn,最后是来自传入特征图的方向。为了得到

适当的方向,我们通过向其添加复角来修改常用的Grid-RPN方法:

(4)

借助此扩展,E-RPN根据直接嵌入到网络中的虚部和实部来估计准确 的对象方向。对于每个网格单元我们预测了五个对象,包括概率得分和类得分,每个对象产生75个特征。

表1输入输出关系图

锚框设计。YOLOv2对象检测器[13]预测每个网格单元有五个盒子。所有这些都使用有利的先验(即锚框)进行初始化,以在训练过程中实现更好的收敛。由于角度回归,自由度(即可能的先验数量)增加了,但出于效率原因,我们没有扩大预测的数量。因此,根据KITTI数据集内的方框分布, 我们仅将三种不同的尺寸和两个角度方向定义为先验:

- 车辆尺寸(抬头);

ii)车辆尺寸(朝下);

iii)骑单车的人数(抬头);iv) 骑车人的人数(朝下);v)行人大小(朝左)。

复角度回归。每个对象bphi;的方向角可以从负责的回归参数tim和tre计算, 它们对应于复数的相位,类似于[27].通过使用arctan2(tim,tre)即可简单地给出角度。一方面,这避免了奇点;另一方面,这导致了封闭的数学空间,因此,这对模型的推广具有有利的影响。rpn我们可以将回32x归16x参75数直接链接到损失函数中。

图3 3D边界框回归

我们根据YOLOv2中显示的回归参数预测定向的3D边界框,以及用于框定向的复杂角度。从2D到3D的过渡是基于每个类别的预定高度完成的。

2.3损失函数

我们的网络优化损失函数L基于YOLO的概念[12] 和YOLOv2[13],他使用引入的多部分损失将尤洛定义为平方误差的总和。我们通过Euler re-

回归部分欧拉以使用复数,该复数具有用L于角度比较的封闭数学空间。

这种忽略的奇异性在单角度估计中很常见:

L =LYolo LEuler (5)

损失函数的Euler回归部分是借助EulerRegion-Proposal定义的。假设预测的复数和地面实数之间的差(即|z|eibphi;和| zcirc; |eibphi;)

始终位于z= 1和zcirc; = 1的单位圆上,则最小化平方误差的绝对值得到真正的损失:

其中是确保在早期阶段稳定收敛的比例因子,而1对象则表示与该 预测的地面真相相比,单元格i中的第j个边界框预测因子具有最高的ij,相交联合(IoU)。此外,比较带有IoU

cap;的预测框P 和地面实况G,其中Pjcap;G = {x:xisin;Pjand;xisin;G},Pj

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[239458],资料为PDF文档或Word文档,PDF文档可免费转换为Word