故障字典诊断方法在测试领域的应用外文翻译资料

2022-12-11 20:13:06

英语原文共 15 页,剩余内容已隐藏,支付完成后下载完整资料

什么是显著目标?显著目标检测的一个数据集和一个基线模型

摘要—显著目标检测或显著区域检测模型,与定位预测模型不同,传统上处理定位和分割图像中最显著目标或区域。尽管当场景中存在多目标时最显著目标的概念是合乎情理的,但当前评价显著性检测方法的数据集通常只包含一个单一目标。这篇文章我们引入三个主要贡献。第一,我们通过研究人们观察场景中的位置和当他们被明确要求时选择作为最显著目标的物体之间的关系来深入地考虑显著目标检测的问题。基于定位和显著性判断之间的一致,我们认为最显著目标是引起最高分数的定位的部分。第二,我们提供两个新的没有偏颇的基本数据集,它包含挑战现有显著性模型的多目标的场景。事实上,我们观察到我们的数据集上的八个最新的模型的性能有严重的下降(40%—70%)。第三,我们基于超像素提出一个很简单但强大的模型用来作为模型评估和对比的基线。我们的模型与MSRA-5 K数据集上最好的模型平分秋色,但我们的数据突出了围绕在最显著目标的定位和分割的过程中的现有模型严重的缺陷,这一点胜过其他模型。我们也提供了一些能用来评估显著目标检测模型的有标签的场景数据集的评估和统计分析。我们认为我们的工作能大大地帮助补救模型对现有偏颇数据集的过度拟合并且打开这个快速发展领域未来研究的新天地。

关键词—显著目标检测,显示显著性,自底向上的注意,兴趣区域,眼球运动。

- 介绍

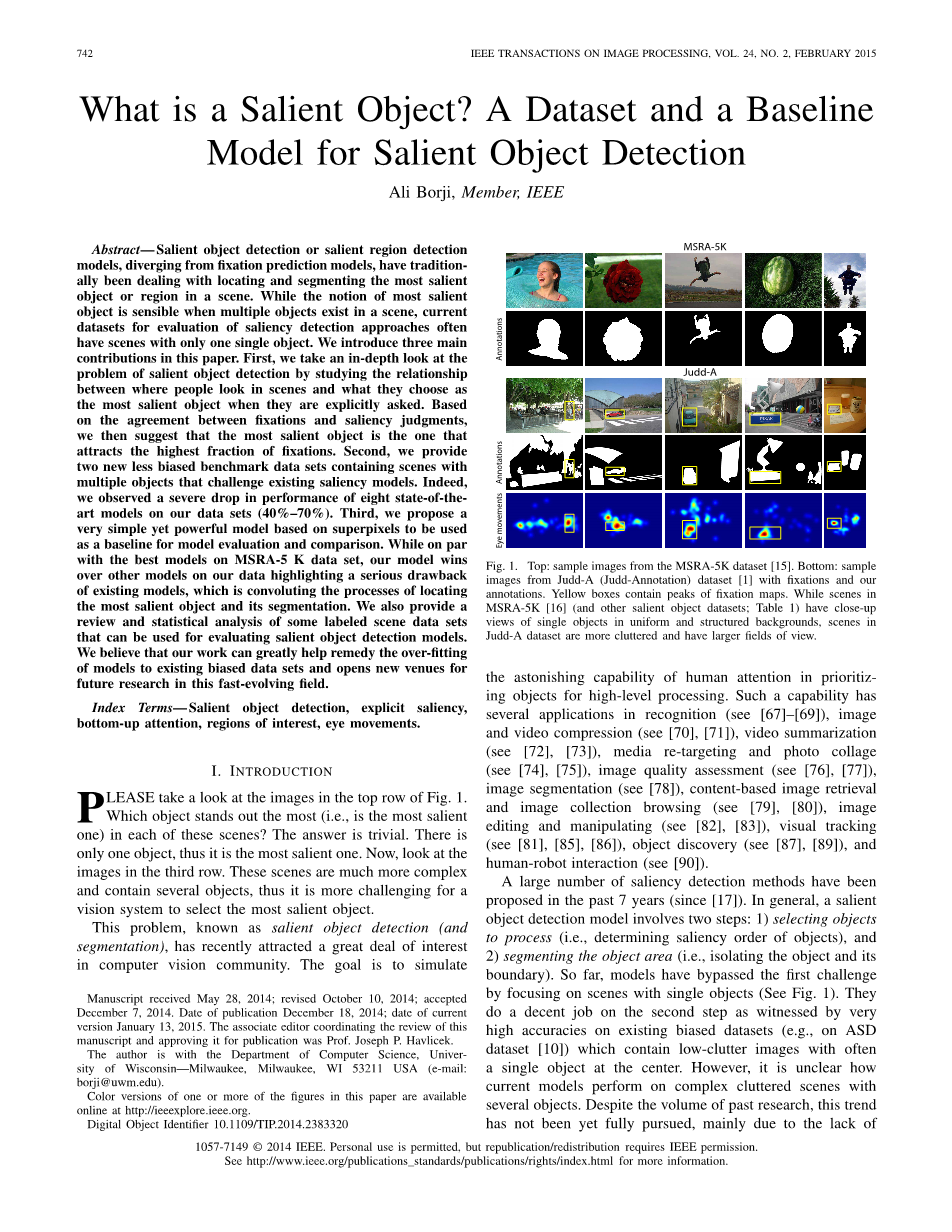

请看图1顶部的图像。每个场景中最突出的物体(即是最显著的)是哪个?答案是无价值的。图像中只有一个物体,所以它就是最显著的目标。现在,观察第三排的图像。这些场景更加复杂并包含几个物体,所以这对于视觉系统选择最显著目标更有挑战性。

图1. 顶部:来自MSRA-5K数据集[15]的范例图像。底部:来自Judd-A(贾德—注释)数据集[1]的有定位和我们的释文的范例图像。黄盒包含定位图的峰。MSRA-5K[16](和其他显著目标数据集;表1)中的场景有同一和结构的背景中单一物体的特写镜头,而Judd-A数据集中场景更加混乱并有更大的视野。

这个问题,称作显著目标检测(和分割),最近吸引了计算机视觉领域的许多兴趣。目标是模拟为了高级处理而排序目标的人类注意的惊人能力。这样的能力在识别(见[67]-[69]),图像和视频压缩(见[70],[71]),视频摘要(见[72],[73]),媒体重新定向和图片拼接(见[74],[75]),图像质量评估(见[76],[77]),图像分割(见[78]),基于内容的图像检索和图像采集浏览(见[79],[80]),图像编辑和操作(见[82],[83]),视觉追踪(见[81],[85],[86]),目标发现(见[87],[89]),以及人机交互(见[90])中有很多应用。

大量的显著性检测方法在过去7年中被提出(从[17])。总的来说,一个显著目标检测模型包含两个步骤:1)选定对象来处理(即决定目标的显著性顺序),2)分割目标区域(即分离目标和它的边界)。目前为止,模型通过集中有单一物体的场景(见图1)而绕过了第一个问题。这些模型对第二个步骤做了适当的工作来证明现有的偏颇数据集(如在ASD数据集[10])上的超高准确度,这些数据集包含中心通常有一个单一物体的低混乱图像。但是,现有模型如何处理有多个物体的复杂混乱图像是不清楚的。不管过去的研究有多少,这个趋向还没有被完全研究,主要因为缺乏两个组分:1)扩大模型和模型开发的适当的基准数据集;2)对最显著目标的广泛一致的客观的定义。这篇文章,我们试图提供解决这些问题的方案。进一步地,我们打算发现哪个部分可能是当移至复杂场景时模型可能出现的失败中的最弱链。

一些与视觉显著性建模和显著目标检测相关的课题,或近或远,包含:目标重要性[46],[47],目标建议产生[27],记忆性[48],场景混乱[49],图像兴趣度[51]-[53],视频兴趣度[50],惊奇[54],图像质量评价[55],场景典型性[56],[57],审美[53],以及特性[58],[59]。

- 相关工作

最早的模型之一由Itti等人[2]提出,产生了计算机视觉和神经科学共同体中图像显著性的兴趣的第一次浪潮。这个模型是早期综合计算结构和基于中心—环绕机制的自底向上注意的心理理论的实现。在[2]中,Itti等人展示了例子,他们的模型能够检测到场景中的空间间断点。随后的行为(见[41])和计算(见[3])的研究开始用显著性模型预测定位来证明模型以及理解人类的视觉注意。兴趣的第二次浪潮随着Liu等人[17]和Achanta等人[10]的工作出现,他们将显著性检测看做一个二进制分割问题,1代表一个前景像素而0代表背景区域的一个像素。此后,当这个新定义和其他已确定下来的计算机视觉领域(例如综合分割算法(见[34],[35]),分类独立目标提案(见[27]),定位预测显著性模型(见[1],[3],[4]),以及综合目标检测方法)共享很多概念时,它代表的区域是不明确的。这一部分是因为当下数据集已经形成了这个问题的定义,可能不能完全地反映模型选择和分割任意复杂水平的图像中的显著目标的全部潜能。

检验所有显著性检测模型超出了这篇文章的范围(见[26],[30],[39],[88])。一些突破性进展如下。Liu等人[17]引进了条件随机域(CRF)框架来联合基于二维显著性估计的周围,环境和颜色空间分布的多尺度对比和局部对比。Achanta等人[10]等人提出了从显著性检测的低通滤过的输入中减去平均颜色。Goferman等人[9]使用一个块拼贴的方法来合并全局环境,旨在检测能代表场景的图像区域。Cheng等人[14]提出了一个区域对比的方法来测量实验室颜色空间中的全局对比。在[11]中,Wang等人估算了局部显著性,扩充了从其他图像中学到的字典,并且全局显著性使用了一个从相同图像的其他补丁学到的字典。Perazzi等人[29]观察到将一个图像分解成视觉上均匀的区域从而提取出不必要的细节,对于高性能的显著性检测时重要的。在[15]中,Jiang等人利用了一个区域的颜色直方图和它的测量显著性的直接相邻区域之间的差别。Feng等人[12]定义了一个显著性的测度,为使用图像的剩余部分组成一个图像窗口的成本,并在PASCAL VOC数据集[84]上检测它。这个方法,本质上,和[27]有相同的目的。Chang等人[14]提出了融合通用对象[27]的图解模型和显著目标检测的视觉显著性。Shen和Wu[38]将图像模拟为特征空间中的一个低秩矩阵(背景)加上稀疏噪音(显著区域)。最近以来,Margolin等人[37]将图案和颜色的不同与高水平线索结合起来,来测量图像碎片的显著性。

一些研究考虑了与[64]相似的定位和显著性判断之间的关系。例如,Xu等人[43]研究了自然场景的自由视角中定位预测的高水平语义知识(如,目标可操作性,注意性,注视方向)和目标信息(如,目标中心偏向)的作用。他们构造了一个叫做“目标和语义图像和眼球追踪(OSIE0)”的大的数据集。事实上他们为定位预测建立了这个信息的附加值并且提出了一个改善定位预测性能的回归模型(来发现不同线索的综合权重)。Koehler等人[44]收集了被称为UCSB数据集的数据集。这个数据集包含800个图像。一百个观察者完成一个明确地显著性判断任务,22个观察者完成一个自由视角的任务,20个观察者完成显著性搜寻的任务,38个观察者完成线索目标搜寻任务。显著性搜寻任务中的观察者被指示来确定图像中的最显著目标或区域是在场景的左半边还是右半边。最后,完成线索目标搜寻任务的观察者被要求确定图像中是否存在目标物体。然后,他们引导基准并引入最好完成每个任务的模型。

这篇文章中和我们的工作相似行业被Mishra等人[23]提出,他们将单眼线索与立体声和运动特征结合起来,来分割考虑初始指定的种子点的区域,实际上忽略了显著性检测(这里我们通过自动生成一个种子点来处理)的第一个步骤。最后,这个工作中我们企图是连接交互式分割算法和显著性检测模型,并帮助超越它们的适用性。

可能与我们的工作最相似的工作是由Li等人[42]发布的。在他们的工作中,他们提供了两大贡献。第一,他们使用来自PASCAL数据集[84]的带注解的图像收集了眼运动数据集,并称他们的数据集为PASCAL-S。第二,他们提出了一个胜过这个数据集(也是四个其他基准数据集)上的其他最新的显著目标检测模型的模型。他们的模型将显著目标检测问题分成两个过程:1)分割产生过程;2)使用定位预测的显著性得分机制。这里,同Li等人相似,我们也利用眼运动来测量目标显著性,但是不是首先完全的分割场景,我们使用超像素完成一个浅层的分割。然后我们仅仅集中于分割最可能吸引注意力的目标。换句话说,这两个步骤和Li等人的相似,但顺序相反。这可能潜在地导致更好的效率因为第一个昂贵的分割部分现在仅仅是近似值。

我们同样提供了另一个与Li等人的互补的数据集,并且这两个数据集(以及模型)有望引起显著目标检测领域的典范转移来避免使用简单的偏颇数据集。进一步地,我们将这个领域置于其他相似领域(例如综合目标检测和分割,目标方案生成模型以及定位预测的显著性模型)之中。

几个显著目标检测数据集被建立因为更多的模型被引入到文献中来扩展对于更复杂场景的模型的能力。表1列出了19个普及的显著目标检测数据集的性能。尽管这些数据集有一些偏差(如,低的场景混乱,中心偏离,一致的背景以及清晰的物体),但它们对于过去的发展有非常大的影响。不幸的是,近期扩展现有数据集的努力仅仅增加了图像的数量而没有真正地处理核心问题特别是背景混乱和物体的数量。数据集的大部分(尤其是大规模的那些例如来源于MSRA数据集)包含有一个通常在图像中心的物体的场景。这使得模型评价具有挑战性,因为一些突出图像中心的高性能的模型没有检测和分割出最显著的偏离中心的目标[30]。我们认为现在应该将中心移到更通用的数据集并且纠正显著目标数据集中的偏差。

- 什么是显著目标?

在这部分,我们简略的解释显著目标检测模型是如何区别于定位预测模型的,当人们被明确地要求选择最显著目标时他们考虑的是什么,这些判断和眼运动之间有什么关系,以及显著目标检测模型实际上预测的是什么。

我们从当人们被明确要求选择这样的目标时他们的观点来研究显著目标的特性。然后我们研究显著性判断是否与眼运动一致。尽管人们假设眼运动是显著目标的指标,但目前为止很少有研究(见[63],[64])直接定量地确认这一设想。此外,一致的等级以及定位和显著性判断之间的差异的情况还没有被完全开发出来。一些研究(见[28]),表明观察者决定先注解显著目标或区域但是他们没有明确地要求人们(LableMe数据在[28]中被分析)并忽略了眼运动。当人们打算分析一个模型的产生时,得知人们将哪些物体看做是显著的是非常重要的。

表1

常见的显著目标数据集的概述。

- 显著目标检测vs.定位预测

定义显著性为“人们看的地方”的模型和定义显著性为“突出的物体”的模型之间有两个主要的区别。第一,前者旨在预测通常3到5秒人们在自然场景的自由视角中看到的点,而后者旨在检测和分割显著对象(通过画出它们周围的像素精确轮廓)。原则上,在一个问题上处理得好的模型应该在其他问题上处理得不是很好。定位预测的一个最优化模型应该仅突出那些观察者会看到的点(目标内少数点且不是整个目标区域)。由于显著目标检测模型旨在分割整个目标区域,所以就定位预测而言,它们将生成许多错误信息(这些点属于目标但观察者未必会看到它们)。相反,当将一个定位预测模型应用到分割上时,将丢失目标内的很多点(如,漏报率)。

第二,由于眼球追踪或观察者的扫视着陆中(典型地大约在1到30个像素)的噪音,高精确的像素级预测图是不被期望的。事实上,由于这些噪音,有时模糊的预测图增加了得分[25],[42],[60]。相反,产生能准确地区分目标边界的显著目标检测图是非常可取的,尤其在应用中。由于这些因素,不同的评价和基准被开发来对比这两个类别的模型。

事实上,无论模型是处理分割还是定位预测,它们都可交换地适用因为每个都能生成相似的显著图。例如,几个研究报告已经将初始用来预测定位的模型的显著图二值化,来检测和分割显著第一目标(见[61],[62])。

B.人类明确的显著性判断

在我们之前的研究[64]中,我们解决了一个场景中人们看做最突出(即显著)的目标的物体。在[64]中我们研究了来自行为观点的明确的显著性问题,而这里我们主要研究的是构造任意视觉场景中的自动显著目标检测的计算模型。南加州大学在校的70个学生(13个男生,57个女生),他们的视觉正常或矫正到正常且年龄在18到23之间(平均值为19.7,标准=1.4),他们被要求在最突出的物体周围画多边形。参与者的作答假定不是太松(普通)也不是太紧(特殊)。为了这个目的研究者向他们展示了一个例子。参与者能够从一个物体到另一个而重新安置他们的绘图或修改绘图的轮廓。我们关心图像中单个最显著目标的选择的情况。促进因素是来自Bruce和Tsotsos(2005)[3]的数据集的图像。图2是来自这个数据集的范例图片。

图2:来自Bruce-A数据集[3]的范例图像和嵌入定位的标注热图。眼低/眼高表明依据搅乱的AUC得分[39]测量眼运动的低/高一致。凹陷—低/高表明使用第三部分.B中的方程的显著性标注的低/高一致。

我们首先使用下面的定量测度来测量参与者的答案相互一致的程度:

(1)

其中和是第i个和第j个参与者的答案,分别(来自n=70的参与者)在第k个图像上。当使用者的分割中没有重叠部分时,上述措施有明确定义的下限为0,当分割有完美的重叠时,上限为1。图3(左)显示了r值的直方图。参与者互相有稳健的一致性(平均值r=0.37;标准0.17;显著地超过了偶然性)。最低r值得图像的检

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[30996],资料为PDF文档或Word文档,PDF文档可免费转换为Word