基于忆阻器的深度学习网络结构设计与裁剪毕业论文

2020-03-14 12:17:16

摘 要

忆阻器(记忆电阻)的阻值可以根据外加电压(或电流)变化,还具有体积小(纳米级)、功耗低、易存储和非易失性等优点,在存储领域及人工神经网络领域有非常好的应用前景。本文简单介绍了卷积神经网络和忆阻器的3种模型(惠普模型、阈值模型和分段线性模型)并用阈值模型在MATLAB中搭建了卷积神经网络,应用MNIST(Mixed National Institute of Standards and Technology database)数据集对网络进行了训练,并最终实现了对手写体数字的识别。其中,卷积神经网络的训练部分是通过软件进行的,这样可以简化忆阻器网络的结构,节省内存,提高网络运行的效率。为了进一步减少网络的复杂度,本文还对网络进行了“裁剪”,使得卷积神经网络的效率进一步的提高,但作为代价,神经网络的准确率略有下降。基于传统冯诺依曼结构的计算机体系,由于CPU(Central Processing Unit)与内存之间的运算速度的差异,出现了“内存墙”,使得计算机科学的发展遇到了瓶颈。记忆电阻作为新兴的二端元器件,可以进行运算和存储,还具有体积小,能耗低,非易失性等特点,在未来具有非常广泛的应用前景。深度学习近几年在异军突起,俨然已经成为时代的潮流,这之中,卷积神经网络发挥了巨大的作用,其在图像识别,视频处理等方面的应用取得了非常好的效果。本文将忆阻器和深度神经网络结合起来,是对忆阻器在深度学习方面应用的探索。

关键词:忆阻器;卷积神经网络;裁剪;深度学习

Abstract

The memristor (memory resistance) can be changed according to the applied voltage (or current). It also has the advantages of small volume (nanoscale), low power consumption, easy storage and non-volatile. It has a very good application prospect in the field of storage and artificial neural network. In this paper, the convolution neural network and three models of resistor (HP model, threshold model and piecewise linear model) are introduced, and the convolution neural network is built in MATLAB with threshold model. MNIST (Mixed National Institute of Standards and Technology database) data set is used to train the network, and finally the handwritten number recognition is realized. The training part of convolutional neural network is carried out by software, which can simplify the structure of the resistive network, save memory and improve the efficiency of network operation. In order to further reduce the complexity of the network, the network is "clipped" to further improve the efficiency of the convolutional neural network, but as a cost, the accuracy of the neural network is slightly reduced. Based on the traditional von Neumann architecture computer system, the memory wall appears due to the difference between CPU and memory, which makes the development of computer science meet the bottleneck. Memristor is used as a new two-terminal component. It also has the characteristics of small size, low energy consumption, non-volatile and so on. It has a very wide application prospect in the future. In recent years, deep learning has become the trend of the times, and the convolution neural network has played a great role in image recognition, video processing and other applications. In this paper, the combination of the resistor and the deep neural network is the exploration of the application of the memristor in the deep learning.

Key Words:memristor;convolution neural network;pruning;deep learning

目 录

第1章 绪论 1

1.1 背景、目的和意义 1

1.2 国内外的研究现状 4

1.2.1 忆阻器的研究现状 4

1.2.2 深度学习的研究现状 4

1.3 研究内容及预期目标 6

第2章 方案论证 7

2.1 离线训练与在线训练 7

2.2 总体设计方案 7

第3章 忆阻器 8

3.1 惠普模型 8

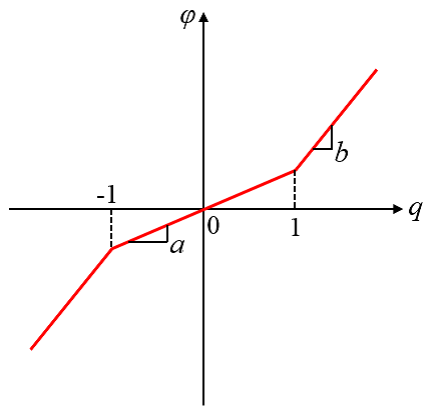

3.2 阈值模型 9

3.3 分段线性模型 10

第4章 卷积神经网络 11

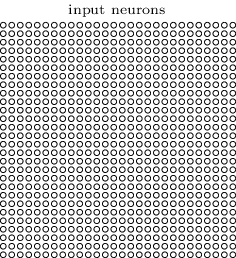

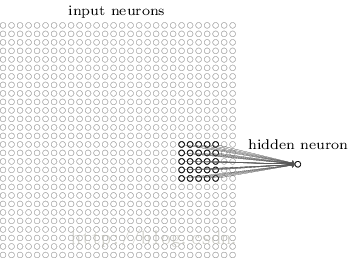

4.1 输入层 11

4.2 卷积层 12

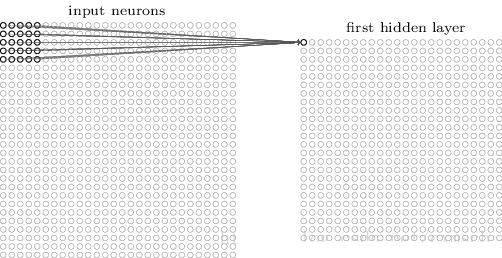

4.2.1 参数共享 14

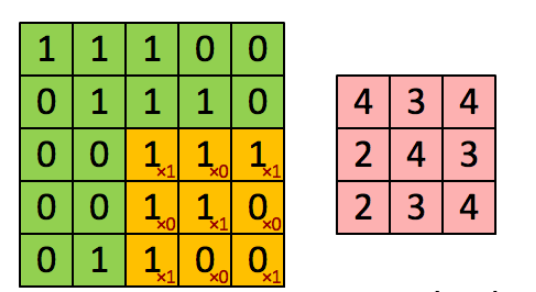

4.2.2 卷积操作 14

4.3 池化层 16

4.4 全连接层 16

4.5 激活函数 16

4.5.1 Sigmoid函数 17

4.5.2 tanh函数 18

4.5.3 ReLU函数 18

第5章 基于忆阻器的卷积神经网络 20

5.1 忆阻交叉阵列 20

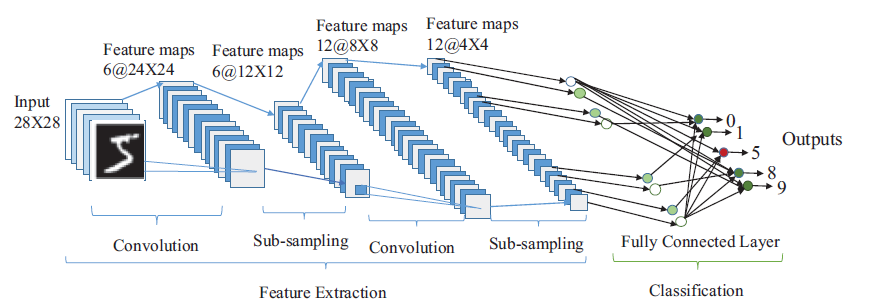

5.2 卷积神经网络识别系统 22

5.2.1 第一层卷积层 22

5.2.2 第一层池化层 23

5.2.3 第二层卷积层 24

5.2.4 第二层池化层 25

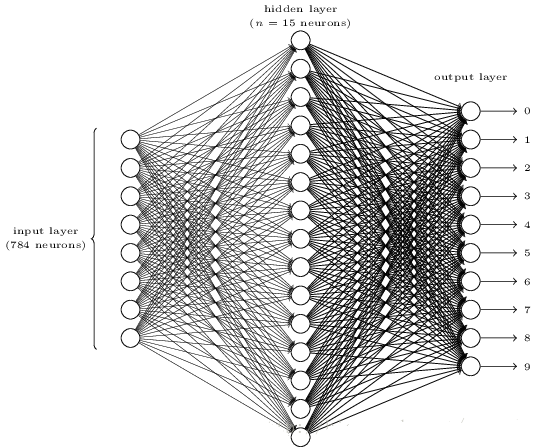

5.2.5 全连接层 25

5.3 实验过程 27

5.3.1 数据集 27

5.3.1 在软件中训练神经网络 27

5.3.2 实验结果 29

第6章 优化卷积神经网络 31

6.1 优化策略 31

6.2 Group-Lasso 32

6.3 实验过程 32

6.3.1 网络的优化稀疏 32

6.3.2 网络的测试 33

6.3.3 实验结果 35

第7章 总结 36

参考文献 37

致谢 40

第1章 绪论

当下,人工智能的热度持续升温,国务院近来也发布了关于人工智能的发展计划,计划中宣布到2030年要在人工智能领域取得重大突破,抢占人工智能全球制高点。人工智能的发展已经给很多领域带去了福音,不仅带来了不可估量的经济效益,还方便了人们生活的方方面面。Hinton等人的不懈研究使得深度学习重新焕发生机,推动深度学习在全球的迅速发展,而深度学习作为人工智能的一个分支,不可避免的促进了人工智能的快速发展[1]。作为深度学习功臣之一的深度卷积神经网络在图像识别领域取得了巨大成就,原因便是其具有良好的表达能力,但由于神经网络的固有特性,不可避免的导致了较复杂的网络结构和庞大的参数集,这在一定程度上限制了深度神经网络的应用。因此,对深度神经网络的压缩和裁剪显得尤为关键。在此背景下,本文对深度神经网络的稀疏和优化进行了研究。

算法的设计和改进是当前深度学习研究的热点,各种各样的模型层出不穷,倒也取得了不错的效果,但是无论何时,硬件算力都是深度学习发展必不可少的一环。没有硬件算力的强大支持,深度学习的发展脚步必然会受到限制。况且,大数据时代的到来,随着数据量的飞速增长,深度学习模型的结构会越来越复杂,网络的规模也会越来越大,这对硬件来说也是一个严峻的挑战。不过,当前的主流仍是采用CMOS技术制造的计算机,但随着“摩尔定律”的逐渐失效,传统CMOS器件的集成度已经很难再进一步提高,这使得计算机技术陷入了泥潭,在此技术上突破或者寻找新的技术迫在眉睫。直到2008年,一种新型的无源二端元器件进入人们的视线,这便是忆阻器(记忆电阻)。纳米级的尺寸,低能耗,非易失性等特点,使它受到了世界各地研究所的关注。经过一段时间的探索,发现忆阻器是打破现有计算机技术瓶颈最有希望的器件之一,由于忆阻器的固有特性与生物突触的性质非常类似,许多研究团队将它用于构建人工神经网络,类脑计算也有了飞速的发展。跟随科学家的脚步,本文也对忆阻器的特性进行研究,并用忆阻器搭建深度学习网络实现图片识别的功能。

1.1 背景、目的和意义

美国加州大学伯克利分校的华裔科学家蔡少棠教授,早在1971年,就从理论上预言了记忆电阻的存在[2]。忆阻器理论上就是表示磁通量与电荷关系的无源二端元器件。直到2008年,惠普实验室的研究团队才制造出了忆阻器的实物[3]。

蔡少棠教授的论文对记忆电阻的存在进行了理论分析,并用数学公式对其模型进行了推理。论文中提供了记忆电阻的原始理论架构,推测记忆电阻即使在没有通电的情况下,依然具有记忆功能。从一般意义上讲,记忆电阻是一种具有记忆能力的非线性电阻。记忆电阻有两个比较明显的状态,高阻状态和低阻状态,通过控制外加的电压(或电流)便可以改变记忆电阻的状态,这两个状态类似计算机中的“1”和“0”,可以实现数据的存储功能。

惠普实验室的研究人员证实在纳米级的电子系统中存在忆阻现象时,便立刻震动了学术界,蔡少棠教授更是感到非常激动,他表示已被搁置将近40年的忆阻理论,竟然被证明是确实存在的,他感到不可思议,同时也对忆阻器的实物非常感兴趣。惠普实验室的研究人员表示,忆阻器最不可思议的一点是能够记忆流经它的电荷量。这与蔡少棠教授的思想是相吻合的,忆阻器的电阻与流经忆阻器的电荷的数量有关。忆阻器的实现,将对神经形态计算及计算机科学产生巨大的影响,可能在不久的未来还会对人们的日常生活带来便利。这都是源于忆阻器电路天然的记忆能力,在没有通电的情况下依然可以保持状态不变。可以畅想一下,你的智能手机在充满电的情况下可以用数周乃至更久,计算机工作者不必担心突然断电而对工作带来的毁灭性打击。这项发现可能用于存储领域和计算机领域,制造性能更好的存储设备,在计算机领域当然是更高效的模拟计算机,为类脑计算的发展打下坚实的基础。

忆阻器可以根据外加的电压(或电流)改变自身的阻值。它天然的记忆特性与生物突触非常相似,是目前已知的最接近突触的电子元件。忆阻器具有实现人工突触的优势:(1)忆阻器是无源元件,断电后仍然可以保持电阻值,即突触的权值,可以实现人工神经网络。(2)忆阻器是模拟器件,作为人工突触可以实现突触权值的平滑更新,符合生物神经网络中突触权值的变化情况。(3)记忆电阻可与CMOS电路集成,比较适合用于人工神经网络电路中。忆阻器交叉阵列可以与CMOS构成的神经元互联,实现超大规模的神经网络。既突破了CMOS 电路集成度的限制,也克服了纳米级电路功能简单的问题,使神经网络电路具有更强大的信息处理能力。(4) 在传统的CMOS电路中,存储器与处理器之间运行速度不匹配。而忆阻器既可以存储,又可以进行逻辑运算,可以降低忆阻神经网络中的能耗,减少运行时间。

就像科幻电影中刻画的那样,人工智能是人类美好的愿望,尽管电影中的人工智能往往会给人类带来毁灭性的打击。经过数十年的持续发展,计算机技术已经发生了翻天覆地的变化,目前计算机表现出来的强大功能与之前想比,简直是天壤之别。然而直到现在,计算机仍然没有达到图灵测试(Turing Testing)的目标,没有一台计算机拥有自己的意识。让机器拥有意识这种不可思议的想法来自英国数学家图灵,他被誉为“计算机科学之父”和“人工智能之父”。

随着时间的流逝,计算机的发展虽然迅速,但距离图灵测试还有很长的路。这使得人们不再相信图灵测试,认为计算机不可能产生所谓的自我意识。然而,深度学习(Deep Learning)就像漆黑夜空中的一道亮光,打破了漫无边际的黑暗,让人们看到实现图灵测试的希望。

深度学习与大脑工作有着密不可分的联系。1981年David Hubel和Torsten Wiesel获得了诺贝尔医学奖,他们的巨大贡献是发现人类视觉系统是分级处理信息的。这个重大发现使得科学家们对深度学习展开了广泛的讨论,这也是深度卷积神经网络的开端。早在1943年,心理学家Warren Mcculloch和数理逻辑学家Walter Pitts便在论文中给出了人工神经元的模型和神经网络的概念,从而将人们带入了人工神经网络研究的时代[4]。1949年,心理学家Donald Hebb在论文中指出,神经网络的学习过程实际上发生在神经元连接之间的突触部位,突触的联结强度在一定程度上可以表示学习的强度[5]。直到1957年,Frank Rosenblatt在《New York Times》上发表文章,首次提出了感知机模型 [6]。

起初,感知机模型被认为非常具有潜力,在相关领域中受到了广泛关注。直到1969年,Marvin Minsky和Seymour Papery在文章中仔细分析了单层感知机在计算能力上的局限性,证明单层感知机不能解决简单的线性不可分问题[7],这使得深度学习的发展再次进入了寒冬,世界上大多数研究所纷纷放弃了对感知机的研究。其实真理一直都在,她在等待一直坚守的科学家们。直到1982年John J.Hopfield博士提出了Hopfield网络以及David E和James L发表了文章《并行分布处理》。这使得人们对人工神经网络的研究再次燃起了信心。此次的研究成果对多层感知器的误差反向传播(Error Back Propagation)算法进行了详细的分析,实现了构建多层网络的设想。然而,误差反向传播即反向传播算法(Backpropagation algorithm,BP)[8],还是在关于如何获取隐层权值的问题上遇到了瓶颈。直到2006年,Geoffrey Hinton对深度学习的提出以及模型训练方法的改进打破了BP神经网络发展的瓶颈。Hinton在论文中表示:(1)多层人工神经网络模型有很强的特征学习能力,深度学习模型学习得到的特征数据对原始数据有更本质的代表性;(2)对于深度神经网络很难训练达到最优的问题,可以采用逐层训练方法解决[9]。

从感知机诞生到神经网络的发展,再到深度学习的提出。深度学习的发展可谓是一波三折,跌宕起伏,经历过辉煌,也陷入过低谷。2006年, Hinton提出深度置信网络(Deep Belief Net:DBN)[10],深度置信网络由一系列受限波尔兹曼机(Restricted Boltzmann Machine:RBM)组成[11],提出了非监督贪心逐层训练算法,这与之后Ruslan Salakhutdinov提出的深度波尔兹曼机(Deep Boltzmann Machine, DBM)[12]重新点燃了人工智能领域对于神经网络和波尔兹曼机(Boltzmann Machine)的热情[13],这才使得人工智能再次升温。目前带监督的卷积神经网络(Convolutional Neural Network, CNN)应用已经十分广泛[14],然而由于标签数据的获得难度越来越大,无监督学习已然悄悄发展起来,奋起直追。

1.2 国内外的研究现状

1.2.1 忆阻器的研究现状

忆阻器的概念最先是由加州大学伯克利分校的蔡少棠教授于1971年提出来的,是一种无缘的二端器件。直到2008年,惠普实验室的研究团队才制造出了忆阻器的实物。2008年以前,有关忆阻器的研究仅仅停留在理论上。现在国内外对忆阻器的研究主要集中在忆阻器特性、忆阻器模型、存储和逻辑运算、人工神经网络和模拟信号处理方面。忆阻器可以与传统CMOS(Complementary Metal Oxide Semiconductor)电路集成,为制造更快更节能且具有生物智能的模拟计算机带来了希望。

STDP是人脑神经网络中一种最基本的学习规则。2008年,惠普实验室使用记忆电阻模拟突触,将记忆电阻和生物突触联系起来,实现了STDP学习规则。相关实验说明当前神经元与后神经元都没有脉冲产生的时候,忆阻器没有电流流过,忆阻器的状态保持不变;当前后神经元产生的脉冲叠加,忆阻器两端的电压大于忆阻器的阈值电压时,忆阻器的阻值才会改变,对应权重得到更新。2011年Zamarreño Ramos C等人证明了可以通过改变忆阻器的外加电压[15],使其实现STDP学习机制,Frank Z. Wang则运用忆阻器建立了简单的神经网络并模拟了巴普洛夫实验,验证了忆阻神经网络可以实现STDP学习规则[16]。西南大学的段书凯小组研究了基于STDP规则的忆阻神经网络在图像存储中的应用,利用忆阻交叉阵列实现了神经网络电路,减小了硬件空间,为灰度图像的存储与输出提供了新的解决方案[17]。

由于忆阻器的无源性、低能耗、易存储以及非易失性等特点,可以用忆阻器构建人工神经网络,忆阻器将对深度学习领域带来新的思路。目前基于忆阻器的神经网络主要用于信号处理、图像识别、混沌电路等。2012年Hyongsuk Kim提出了一种基于脉冲的忆阻桥突触电路,并将设计的电路用于图像处理,通过仿真证明了忆阻突触电路有较好的性能[18];重庆大学的李传东小组寻找适合作为突触的忆阻器模型,对HP模型进行了改进,提出了一种新的HP模型,新的忆阻器模型在神经网络中具有能耗小、效率高的优点[19]。华中科技大学的曾志刚小组将忆阻器引入Hopfield神经网络中,讨论得出了连续的忆阻递归神经网络是一个网络序列[20]。王丽丹等人建立了忆阻器电导和突触权重之间的联系,将忆阻器用于契比雪夫神经网络中[21],朱玄等人提出了基于CMOS忆阻器混合设计的汉明码神经网络,并在忆阻器交叉阵列中进行了展示和验证了识别和分类功能[22]。

以上是毕业论文大纲或资料介绍,该课题完整毕业论文、开题报告、任务书、程序设计、图纸设计等资料请添加微信获取,微信号:bysjorg。

相关图片展示: